Fillimi i etiketimit të dhënave Scale AI mbledh 1 miliard dollarë ndërsa vlerësimi dyfishohet në 13.8 miliardë dollarë

Scale AI, e cila ofron shërbime të etiketimit të të dhënave për kompanitë që duan të trajnojnë modele të mësimit të makinerive, ka mbledhur një raund prej 1 miliard dollarësh të Serisë F nga një mori investitorësh institucionalë dhe të korporatave emra të mëdhenj që përfshijnë Amazon dhe Meta.

Mbledhja e fondeve është një përzierje e financimit parësor dhe dytësor, dhe është e fundit në një mori investimesh të mëdha kapitale në AI. Amazon kohët e fundit mbylli një investim prej 4 miliardë dollarësh në rivalin e OpenAI, Anthropic, dhe kompani si Mistral AI dhe Perplexity janë gjithashtu në procesin e mbledhjes së më shumë raundeve miliardë dollarësh në vlerësime të larta.

Përpara këtij raundi, Scale AI kishte mbledhur rreth 600 milionë dollarë në historinë e saj tetëvjeçare, duke përfshirë një Serinë E prej 325 milionë dollarësh në 2021 që e vlerësonte atë në rreth 7 miliardë dollarë – dyfishi i vlerësimit të Serisë D të saj në 2020 . Tre vjet më vonë, dhe pavarësisht nga erërat e kundërta që e shkaktuan atë të pushonte 20% të stafit të saj vitin e kaluar, Scale AI tani vlerësohet në 13.8 miliardë dollarë – një shenjë e kohës, ndërsa investitorët përpiqen të ecin përpara në nxitimin e arit të AI.

Seria F u drejtua nga Accel, i cili gjithashtu udhëhoqi Serinë A të kompanisë dhe mori pjesë në raundet e sipërmarrjes pasuese.

Përveç Amazon dhe Meta, Scale AI ka tërhequr një shumëllojshmëri investitorësh të rinj: Sipërmarrësit e Cisco, Intel, AMD dhe ServiceNow morën pjesë, ashtu si DFJ Growth, WCM dhe investitori Elad Gil. Shumë nga investitorët e saj ekzistues u kthyen gjithashtu: Nvidia, Coatue, Y Combinator, Index Ventures, Founders Fund, Tiger Global Management, Thrive Capital, Spark Capital, Greenoaks, Wellington Management dhe ish-CEO i GitHub, Nat Friedman.

Të dhënat janë gjaku i inteligjencës artificiale, kjo është arsyeja pse kompanitë e specializuara në menaxhimin dhe përpunimin e të dhënave po ecin mirë tani. Vetëm javën e kaluar, Weka tha se grumbulloi 140 milionë dollarë në një vlerësim pas parasë prej 1.6 miliardë dollarësh për të ndihmuar kompanitë të ndërtojnë tubacione të dhënash për aplikacionet e tyre të AI.

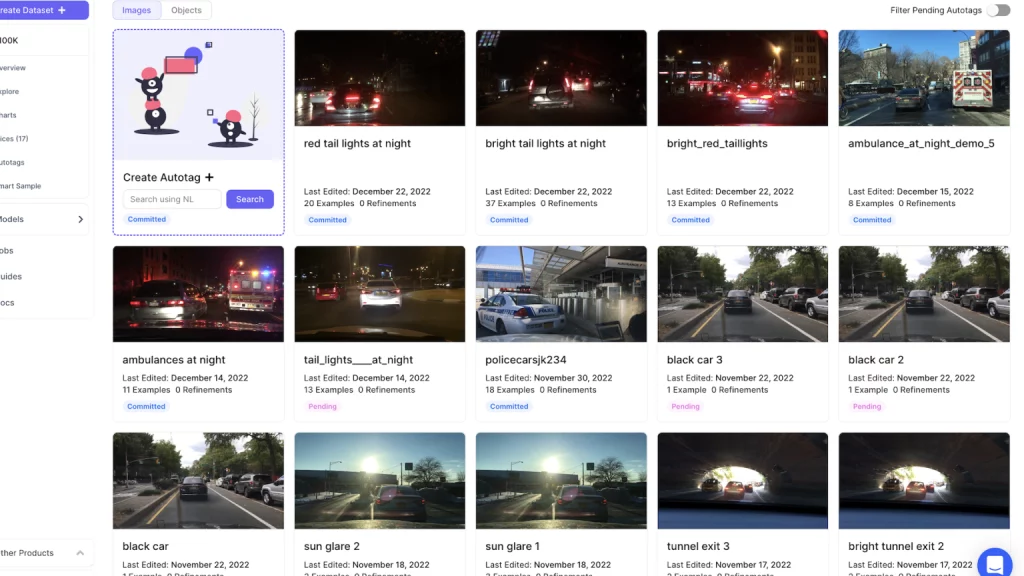

E themeluar në vitin 2016, Scale AI ndërthur mësimin e makinerive me mbikëqyrjen “njerëzore në lak” për të menaxhuar dhe shënuar vëllime të mëdha të dhënash, gjë që është jetike për trajnimin e sistemeve të AI në industri të tilla si automjetet autonome.

Por shumica e të dhënave janë të pastrukturuara dhe sistemet e inteligjencës artificiale e kanë të vështirë t’i përdorin të dhëna të tilla jashtë shkop. Duhet të etiketohet, gjë që është një përpjekje intensive për burime, veçanërisht me grupe të mëdha të dhënash. Scale AI u ofron kompanive të dhëna që janë shënuar në mënyrë korrekte dhe të përgatitura për modelet e trajnimit. Ai gjithashtu specializohet për industri të ndryshme me nevoja të ndryshme – një kompani e makinave vetë-drejtuese ka të ngjarë të ketë nevojë për të dhëna të etiketuara nga kamerat dhe lidar, ndërsa rastet e përdorimit të përpunimit të gjuhës natyrore (NLP) do të kenë nevojë për tekst të shënuar.

Klientët e kompanisë përfshijnë Microsoft, Toyota, GM, Meta, Departamentin e Mbrojtjes së SHBA-së dhe, që nga gushti i kaluar , krijuesi i ChatGPT OpenAI, i cili po prek Scale AI për t’i lejuar kompanitë të rregullojnë modelet e saj të gjenerimit të tekstit GPT-3.5.

Scale AI thotë se do të përdorë paratë e reja për të ndihmuar në përshpejtimin e “bollëkut të të dhënave kufitare që do të hapin rrugën tonë drejt inteligjencës së përgjithshme artificiale”.

“Bollëku i të dhënave nuk është parazgjedhja – është një zgjedhje,” tha CEO dhe bashkëthemeluesi i Scale AI, Alexandr Wang, në një deklaratë për shtyp . “Kërkon bashkimin e mendjeve më të mira në inxhinieri, operacione dhe AI. Vizioni ynë është ai i bollëkut të të dhënave, ku ne kemi mjetet e prodhimit për të vazhduar shkallëzimin e LLM-ve kufitare shumë më tepër të përmasave. Ne nuk duhet të jemi të kufizuar nga të dhënat për të arritur në GPT-10.”