Modelet e AI mund të kapërcejnë të dhënat e tyre të trajnimit

Hulumtimet e reja tregojnë se modelet gjeneruese të AI mund të tejkalojnë trajnerët e tyre njerëzorë. Studiuesit e quajnë këtë fenomen “transcendencë” dhe e demonstrojnë atë duke përdorur shembullin e shahut.

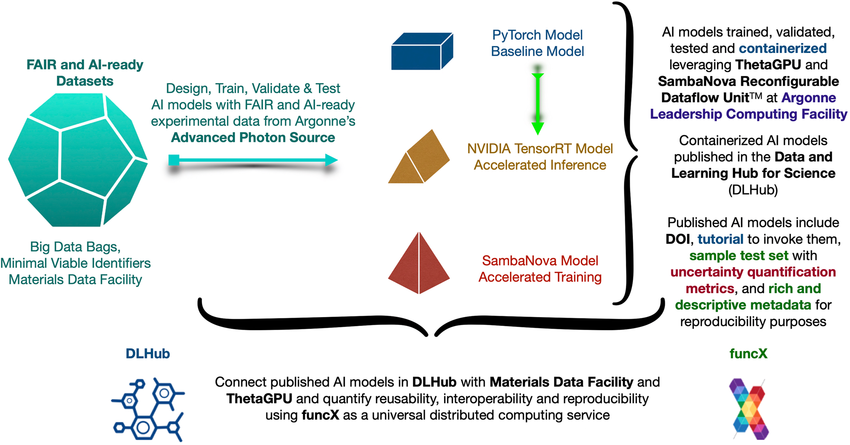

Modelet e AI zakonisht trajnohen për të imituar sjelljen njerëzore. Megjithatë, a është e mundur që këto modele të tejkalojnë “trajnuesit” e tyre njerëzorë në fusha të caktuara? Studiuesit nga Universiteti i Harvardit, UC Santa Barbara dhe Universiteti i Princeton tregojnë në një studim të ri se kjo është e mundur përmes asaj që ata e quajnë “tejkalim”.

Studiuesit trajnuan një transformator në lojërat e shahut të luajtura nga lojtarë me nivele të kufizuara aftësish. Modeli që rezultoi, i quajtur “ChessFormer”, ishte në gjendje të luante më mirë se të gjithë lojtarët në grupin e të dhënave të stërvitjes në disa raste.

Sipas ekipit, kjo tejkalim është bërë e mundur nga kampionimi në temperaturë të ulët, ku zgjidhet gjithmonë vetëm shenja me probabilitetin më të lartë. Me një temperaturë të ulët, një lloj vendimi i shumicës ndodh në mënyrë efektive, duke kompensuar çdo gabim të bërë nga ekspertë individualë dhe duke rritur kështu performancën e modelit mesatarisht mbi performancën e ekspertit më të mirë.

Në eksperimentet e tyre, studiuesit më pas demonstrojnë në mënyrë empirike këtë efekt. Ata trajnuan disa modele ChessFormer në lojëra të luajtura nga lojtarë me vlerësime maksimale ELO prej 1000, 1300 dhe 1500, respektivisht. Ata zbuluan se modelet ChessFormer 1000 dhe ChessFormer 1300 mund të arrinin vlerësime ELO deri në 1500 në temperatura të ulëta, dukshëm më të larta se maksimumi i të dhënave të trajnimit. Studiuesit tregojnë se përmirësimi i performancës në temperatura të ulëta është kryesisht për shkak të lëvizjeve dukshëm më të mira në disa situata kyçe të lojës – me sa duket momente vendimtare që vendosin rezultatin e një loje.

Për më tepër, shkencëtarët zbuluan se diversiteti i të dhënave është një kusht i domosdoshëm për një vendim efektiv të shumicës në praktikë. Modeli i stërvitur vetëm me lojtarë deri në 1500 pikë vlerësimi nuk mund t’i tejkalonte trajnerët e tij njerëzorë. Studiuesit ia atribuojnë këtë mungesës së diversitetit në këtë grup të dhënash: lojtarët me vlerësime më të larta ELO bëjnë më pak gabime që mund të kompensohen me një vendim të shumicës.

Studimi tregon se është e mundur të zhvillohen modele të inteligjencës artificiale që jo vetëm imitojnë ekspertët njerëzorë, por edhe mund të tejkalojnë aftësitë e tyre në fusha të caktuara.

Megjithatë, autorët theksojnë se rezultatet e tyre nuk ofrojnë prova të proceseve të reja të të menduarit abstrakt në AI, por përkundrazi mund t’i atribuohen një efekti denoising. “Ne duam të theksojmë se nuk ofrojmë prova që kampionimi i temperaturës së ulët të çon në arsyetime të reja abstrakte, por më tepër në një denoncim të gabimeve,” shpjegojnë ata.