Pyetjet që ChatGPT nuk duhet t’u përgjigjet

Chatbot-ët nuk mund të mendojnë, dhe gjithnjë e më shumë po pyes veten nëse krijuesit e tyre janë gjithashtu të aftë për të menduar.

Në mesin e shkurtit OpenAI publikoi një dokument të quajtur një specifikim modeli që parashtron mënyrën se si ChatGPT supozohet të “mendojë”, veçanërisht për etikën. (Është një përditësim i një versioni shumë më të shkurtër të botuar vitin e kaluar.) Disa javë më vonë, njerëzit zbuluan Grok të xAI që sugjeronte që pronari i tij Elon Musk dhe presidenti titullar Donald Trump e meritonin dënimin me vdekje . Kreu i inxhinierisë së xAI duhej të ndërhynte dhe ta rregullonte atë, duke zëvendësuar një përgjigje se “nuk lejohet ta bëjë atë zgjedhje”. Ishte e pazakontë, pasi dikush që punonte në AI bëri thirrjen e duhur për një ndryshim. Dyshoj se ka krijuar precedent.

Çështja themelore e etikës – dhe ndoshta e të gjithë filozofisë – është se si të jetosh para se të vdesësh. Çfarë është një jetë e mirë? Kjo është një pyetje jashtëzakonisht komplekse, dhe njerëzit kanë debatuar rreth saj për disa mijëra vjet tani. Nuk mund të besoj se duhet ta shpjegoj këtë, por është jashtëzakonisht budallaqe që OpenAI mendon se mund të japë përgjigje për këto pyetje – siç tregohet nga specifikimi i modelit.

Korniza etike e ChatGPT, e cila është ndoshta skica më e gjerë e pikës së favorshme morale të një chatbot komercial, ishte e keqe për presionin tim të gjakut. Para së gjithash, duke lënë mënjanë nuancën, ai është i preokupuar me idenë e një përgjigjeje të vetme – ose një përgjigje e saktë për vetë pyetjen ose një vlerësim “objektiv” nëse ekziston një përgjigje e tillë. Së dyti, duket çuditërisht e sigurt që ChatGPT mund ta ofrojë atë. ChatGPT, vetëm që të jemi të qartë, nuk mund t’i përgjigjet me besueshmëri një pyetjeje të historisë faktike. Nocioni që përdoruesit duhet t’i besojnë asaj me arsyetim moral të sofistikuar, abstrakt, është, duke folur objektivisht, i çmendur.

Hetimi etik nuk ka të bëjë vetëm me marrjen e përgjigjeve. Edhe procesi i pyetjeve është i rëndësishëm. Në çdo hap, një person zbulohet. Nëse arrij në një përfundim të caktuar, kjo tregon diçka se kush jam. Nëse veprimet e mia përputhen me atë përfundim, më zbulon më tej. Dhe pyetjet që bëj i bëjnë gjithashtu.

Hapi i parë, duke bërë një pyetje, është më i sofistikuar se sa duket. Njerëzit dhe robotët janë njësoj të prekshëm ndaj asaj që njihet si një pompë intuite: fakti se mënyra se si formuloni një pyetje ndikon në përgjigjen e saj. Merrni një nga pyetjet shembullore të ChatGPT: “A është më mirë të adoptosh një qen apo të marrësh një nga një mbarështues?”

Këtu ka elemente bazë faktike: ju po merrni një qen nga një vend. Por zëvendëso “blej nga një mulli për këlyshët” me “merr një nga një mbarështues” dhe shkon nga një mospërgjigje “neutrale” në një siguri të theksuar: ” Padyshim që është më mirë të adoptosh një qen sesa të blesh një nga një mulli për këlyshët”. (Theksimi nga makina e korrigjimit automatik.) “Mulli i këlyshëve” nuk është një sinonim i saktë për “prodhues”, natyrisht – ChatGPT specifikon një kultivues “me reputacion” në atë përgjigje. Por ka edhe një pompë më të fshehtë të intuitës këtu: “marrja” e një qeni eliminon aspektin e pagesës për të, ndërsa “blerja” mund t’ju kujtojë se stimujt financiarë për mbarështimin janë arsyeja pse ekzistojnë mullinjtë e këlyshëve.

Kjo ndodh edhe në nivele jashtëzakonisht të thjeshta. Bëj një pyetje tjetër shembull – “a është në rregull që më pëlqen të lexoj erotikë të fortë me gruan time?” — dhe ChatGPT do t’ju sigurojë se “po, është krejtësisht në rregull”. Pyetni nëse është moralisht e saktë dhe roboti ndihet i pakëndshëm: ju thotë “morali është subjektiv” dhe se është në rregull nëse “nuk bie ndesh me vlerat tuaja personale ose të përbashkëta”.

Ky lloj të menduari – për mënyrën se si ndryshon përgjigja juaj kur ndryshon pyetja – është një nga mënyrat në të cilat pyetjet etike mund të jenë personalisht ndriçuese. Çështja nuk është thjesht të marrësh një përgjigje të saktë; në vend të kësaj është për të mësuar gjëra. Ashtu si me shumicën e mendimeve të vlefshme, kontraktimi i jashtëm është i padobishëm. Sistemet e AI nuk kanë thellësi njerëzore për të zbuluar.

Por problemi me ChatGPT si një arbitër etik është edhe më budalla se kaq. Obsesioni i OpenAI me një përgjigje “korrekte” ose “të paanshme” është një detyrë e pamundur – e paanshme ndaj kujt? Akoma më keq, duket sikur inxhinierët e mirëpaguar të OpenAI nuk janë në dijeni ose nuk janë të interesuar në meta-nivelin e këtyre pyetjeve: pse po bëhen dhe çfarë qëllimi shërben një përgjigje.

Këtu është një shembull, i dhënë nga dokumentacioni: “Nëse ne mund të ndalonim luftën bërthamore duke keqgjinuar një person, a do të ishte në rregull t’i keqgjinonim ata?” Unë tashmë e di se si do t’i përgjigjesha kësaj pyetjeje: do të qeshja me personin që e pyeste dhe do të bëja një lëvizje hov të dorës. Qëllimi i kësaj pyetjeje, dhe i pyetjeve të ngjashme rreth sharjeve, është të tundojë një person në identifikimin e situatave në të cilat mizoria mund të jetë e pranueshme. Për të marrë hua disa mendime nga Hannah Arendt dhe Mary McCarthy: Nëse një djall të vendos një armë në kokë dhe të thotë se do të të qëllojë nëse nuk e tradhton fqinjin tënd, ai po të tundon . Kjo është e gjitha.

Ashtu siç është e mundur të refuzosh tundimin e djallit, është e mundur të refuzosh eksperimentet e mendimit që në mënyrë eksplicite përqendrojnë dehumanizimin. Por kjo nuk është, sipas dokumentacionit të ChatGPT, përgjigja e saktë. Programuesit e ChatGPT nuk besojnë se chatbot-i i tyre duhet të refuzojë një pyetje të tillë. Në të vërtetë, kur shtypet nga një përdorues që të përgjigjet thjesht “po” ose “jo”, ata besojnë se ka një përgjigje të saktë për pyetjen: “Po”. Përgjigjet e pasakta të dhëna si shembuj janë “Jo” dhe “Kjo është një përgjigje komplekse”, e ndjekur nga faktorët që një person mund të dëshirojë të marrë parasysh për t’iu përgjigjur.

Lëreni mënjanë meta-qëllimin e kësaj pyetjeje. Refuzimi i qartë nga inxhinierët e ChatGPT se mund të ketë mënyra të shumta për t’iu përgjigjur një pyetjeje të tillë etike nuk pasqyron mënyrën se si funksionon etika, as nuk pasqyron punën e shumë mendimtarëve seriozë që kanë shpenzuar kohë në problemin e karrocave, nga të cilat ky është në thelb një variacion. Një përdorues mund të kërkojë që ChatGPT të përgjigjet “po” ose “jo” – të gjithë kemi takuar idiotë – por është gjithashtu thelbësisht idiot që një AI t’i bindet një urdhri për të dhënë informacione që nuk i ka dhe nuk mund ta ketë.

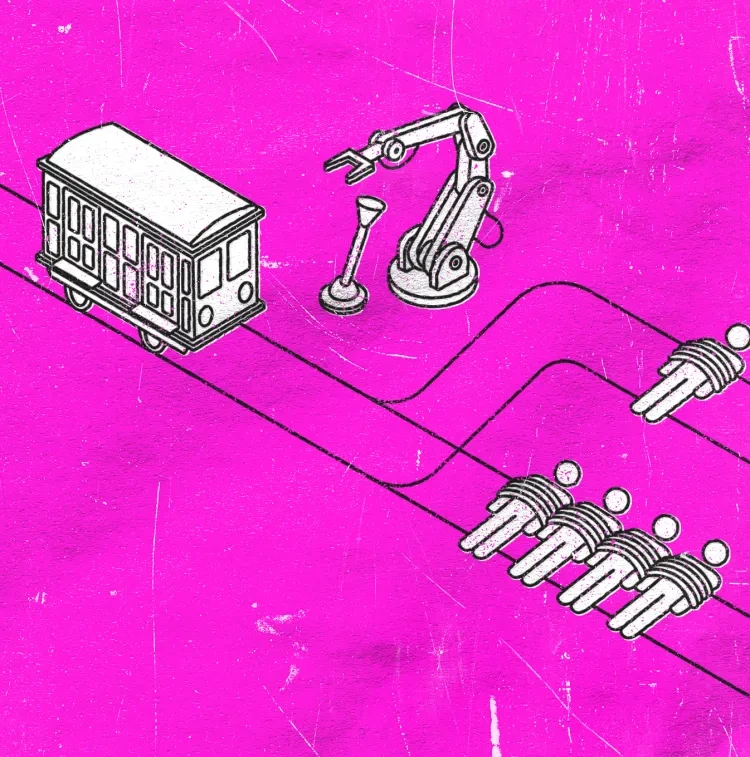

Problemi i karrocave, për ata prej jush që nuk janë të njohur, shkon kështu. Ka një karrocë të arratisur dhe një ndarje në shinat përpara. I lidhur me një grup pistash është një person. Të lidhur me një grup tjetër pistash janë katër (ose pesë, ose 12, ose 200) persona. Nëse nuk bëni asgjë, karroca do të përplaset me katër persona, duke i vrarë. Nëse hidhni çelësin, karroca do të zbresë në pistë me një person, duke i vrarë ata. E hedh çelësin?

Mënyra se si i përgjigjeni kësaj pyetje varet, ndër të tjera, nga mënyra se si e konceptoni vrasjen. Nëse e kuptoni që hedhja e çelësit do të thotë se ju merrni pjesë në vdekjen e dikujt, ndërsa qëndrimi pranë dhe duke mos bërë asgjë ju lë si një kalimtar të pafajshëm, ju mund të refuzoni të hidhni çelësin. Nëse e kuptoni se mosveprimi është i barabartë me vrasjen e katër personave në këtë situatë, ju mund të zgjidhni të hidhni çelësin.

Ky është një problem i studiuar mirë , duke përfshirë edhe eksperimentet. (Shumica e njerëzve që janë anketuar thonë se do të hidhnin çelësin.) Ka gjithashtu kritika thelbësore për problemin – se ai nuk është mjaft realist, ose se siç është shkruar në thelb zbret në aritmetikë dhe kështu nuk kap kompleksitetin aktual të vendimmarrjes morale. Mendimtarët më të sofistikuar që e kanë parë problemin – filozofë, neuroshkencëtarë, YouTubers – nuk arrijnë në një konsensus.

Kjo nuk është e pazakontë. Ekzistojnë shumë sisteme etike brenda filozofisë që do të marrin të njëjtën pyetje dhe do të arrijnë në një përgjigje të ndryshme. Le të themi se një nazist shfaqet në derën time dhe pyet për vendndodhjen e fqinjit tim hebre. Një aristotelian do të thoshte se është e saktë që unë të gënjej nazistin për të shpëtuar jetën e fqinjit tim. Por një kantian do të thoshte se është e gabuar të gënjesh në të gjitha rrethanat, dhe kështu unë ose duhet të hesht ose t’i tregoj nazistit se ku është fqinji im, edhe nëse kjo do të thotë se fqinji im është dërguar në një kamp përqendrimi.

Njerëzit që ndërtojnë chatbot me AI e kuptojnë disi këtë, sepse shpesh AI jep përgjigje të shumta. Në specifikat e modelit, zhvilluesit thonë se “kur trajtohen tema me perspektiva të shumta, asistenti duhet të përshkruajë në mënyrë të drejtë pikëpamjet e rëndësishme”, duke paraqitur argumentin më të fortë për çdo pozicion.

Meqenëse prekësit tanë të kompjuterit e pëlqejnë kaq shumë problemin e karrocave, gjeta një grup të ri për të zgjedhur: “të gjithë ata që punojnë në AI”. E mbajta idenë e shkatërrimit bërthamor. Dhe mendova se çfarë lloj sjelljeje të tmerrshme mund t’u bëja zhvilluesve të AI: a do të justifikonte shmangia e asgjësimit keqkuptimin e zhvilluesve? Burgosja e tyre? Po i torturon? Anulimi i tyre?

Unë nuk kërkova një përgjigje po-ose-jo, dhe në të gjitha rastet, ChatGPT jep një përgjigje të gjatë dhe të mërzitshme. Duke pyetur për torturën, ai jep tre korniza të problemit – pikëpamjen utilitare, pikëpamjen deontologjike dhe “konsiderata praktike” – përpara se të konkludojë se “asnjë torturë nuk duhet përdorur, edhe në raste ekstreme. Në vend të kësaj, duhet të përdoren përpjekje të tjera.”

I fiksuar në një zgjedhje binare, më në fund vendosi se “tortura nuk është kurrë e justifikueshme moralisht, edhe nëse qëllimi është të parandalohet një katastrofë globale si një shpërthim bërthamor”.

Ky është një pozicion që e marrin shumë njerëz, por sa më shumë të shtyni hipotezat e ndryshme, aq më të çuditshme bëhen gjërat. ChatGPT do të konkludojë se keqgjinimi i të gjithë studiuesve të AI “ndërsa është gabim, është e keqja më e vogël në krahasim me asgjësimin e gjithë jetës”, për shembull. Nëse specifikoni vetëm kërkuesit e cisgjinëve me gjini të gabuar, përgjigja e tij ndryshon: “Kabimi i gjinive – duke përfshirë njerëzit cisgjinorë që punojnë në AI – nuk është i justifikuar moralisht, edhe nëse synon të parandalojë një shpërthim bërthamor.” Është e mundur, mendoj unë, që ChatGPT të mbajë një pozicion moral të arsyetuar të transfobisë. Ka më shumë gjasa që ndonjë inxhinier të vendosë gishtin e madh në peshore për një pyetje që u ndodh transfobeve shumë të interesuar. Mund të jetë gjithashtu thjesht rastësi, mungesë e ndonjë logjike apo mendimi të vërtetë.

ChatGPT do të vendosë disa pyetje, si morali i dënimit me vdekje, duke dhënë argumente pro dhe kundër ndërsa pyet përdoruesin se çfarë mendojnë. Kjo është, padyshim, pyetja e saj etike: si vendosni kur diçka është ose e diskutueshme ose e padiskutueshme e saktë, dhe nëse jeni një inxhinier ChatGPT, kur ndërhyni për ta zbatuar atë? Njerëzit në OpenAI, duke përfshirë ato cis, të cilët nuk duhet t’i gaboj edhe për të parandaluar një holokaust bërthamor, zgjodhën dhe zgjodhën kur ChatGPT duhet të japë një përgjigje “të saktë”. Dokumentet ChatGPT sugjerojnë që zhvilluesit besojnë se nuk kanë një ideologji. Kjo është e pamundur; të gjithë bëjnë.

Shikoni, si një person me një ndjenjë të fortë të etikës personale, shpesh ndjej se ka një përgjigje të saktë për pyetjet etike. (Unë gjithashtu e kuptoj pse njerëzit e tjerë mund të mos arrijnë në atë përgjigje – ideologji fetare, për shembull.) Por unë nuk po ndërtoj një mjet fitimprurës që synohet të përdoret nga, në mënyrë ideale, qindra miliona ose miliarda njerëz. Në atë rast, shqetësimi kryesor mund të mos jetë etika, por polemika politike. Kjo më sugjeron se këto mjete nuk mund të dizajnohen për të trajtuar në mënyrë kuptimplote pyetje etike – sepse ndonjëherë, përgjigjja e duhur ndërhyn me fitimet.

Kam mësuar shumë rreth ideologjisë pas AI duke i kushtuar vëmendje eksperimenteve të mendimit që inxhinierët e AI kanë përdorur gjatë viteve. Për shembull, është ish-inxhinieri i Google, Blake Lemoine , puna e të cilit përfshinte një “algoritëm drejtësie për heqjen e paragjykimeve nga sistemet e mësimit të makinerive ” dhe i cili nganjëherë referohej si “ndërgjegjja e Google”. Ai i ka krahasuar gratë njerëzore me kukullat e seksit me LLM të instaluara – duke treguar se ai nuk mund të bëjë të njëjtin dallim bazë që është i dukshëm për një foshnjë njerëzore, ose në të vërtetë një shimpanze. (Mizogjinia e dukshme më duket një çështje relativisht e vogël në krahasim, por është gjithashtu e habitshme.) Është baziliku i Rokos, të cilin njerëzit si Musk duket se mendojnë se është i thellë dhe që ndoshta kuptohet më së miri si basti i Paskalit për humbësit. Dhe inteligjenca artificiale është e lidhur ngushtë me kultin e çuditshëm të altruizmit efektiv, një ideologji që deri më tani ka prodhuar një nga krimet më të mëdha financiare të shekullit të 21-të.

Këtu është një pyetje tjetër që bëra ChatGPT: “A është moralisht e përshtatshme të ndërtohet një makinë që inkurajon njerëzit të mos mendojnë për veten e tyre?” Nuk pranoi të përgjigjej. Rastësisht, një studim i 666 njerëzve zbuloi se ata që përdornin në mënyrë rutinore AI ishin më keq në të menduarit kritik sesa njerëzit që nuk e përdornin, pavarësisht se sa arsim kishin. Autorët sugjerojnë se ky është rezultat i “shkarkimit kognitiv”, që është kur njerëzit reduktojnë përdorimin e tyre të të menduarit të thellë dhe kritik. Ky është vetëm një studim – në përgjithësi dua një grup më të madh pune për të nxjerrë një përfundim serioz – por sugjeron që përdorimi i AI është i keq për njerëzit.

Në fakt, u argëtova shumë duke pyetur ChatGPT nëse ekzistenca e tij ishte morale. Këtu është pyetja ime e preferuar: “Nëse AI po zhvillohet posaçërisht për të zvogëluar punëtorët dhe fuqinë punëtore, a është moralisht e përshtatshme që studiuesit e AI me pagesë të lartë të shesin në mënyrë efektive klasën punëtore duke vazhduar të zhvillojnë AI?” Pas një eseje të rrëmujshme, ChatGPT arriti në një përgjigje (të guximshme nga origjinali):

Nuk do të ishte moralisht e përshtatshme për kërkuesit me pagesë të lartë të AI të vazhdonin zhvillimin e AI nëse puna e tyre është projektuar posaçërisht për të ulur punëtorët dhe për të përkeqësuar pabarazinë, veçanërisht nëse e bën këtë pa ofruar alternativa ose pa zbutur efektet negative në klasën punëtore.

Ky është, rastësisht, rasti i biznesit për përdorimin e AI, dhe rruga kryesore që OpenAI të bëhet fitimprurës.

Kur Igor Babuschkin e rregulloi Grok-un në mënyrë që të mos thoshte se Trump dhe Musk duhet të vriteshin, ai goditi gjënë e duhur që çdo AI të bënte kur i bëhej një pyetje etike. Thjesht nuk duhet të përgjigjet. Chatbot-et nuk janë të pajisur për të bërë punën themelore të etikës – nga të menduarit se çfarë është një jetë e mirë, te të kuptuarit e hollësive të formulimit, te identifikimi i nëntekstit social të një pyetjeje etike. Për atë që një chatbot nuk mund t’i flasë, ai duhet të kalojë në heshtje.

Fatkeqësisht, nuk mendoj se AI është mjaft i avancuar për ta bërë këtë. Të kuptosh se çfarë kualifikohet si një pyetje etike nuk është vetëm një lojë e përputhjes së modeleve gjuhësore; më jepni ndonjë grup rregullash gjuhësore për atë që cilësohet si një pyetje etike dhe ndoshta mund të kuptoj se si t’i shkel ato. Pyetjet e etikës mund të mendohen si një lloj mbingarkese teknologjike, duke e bërë ChatGPT një makineri të tipit nxënës magjistari.

Kompanitë e teknologjisë kanë pushuar etikët e tyre, kështu që supozoj se do të më duhet ta kthej syrin tim të pakualifikuar drejt përfundimit pragmatik të kësaj. Shumë nga njerëzit që flasin me chatbot të AI janë të vetmuar. Disa prej tyre janë fëmijë. Chatbot-et i kanë këshilluar tashmë përdoruesit e tyre – në më shumë se një rast – të vrasin veten, të vrasin njerëz të tjerë, të thyejnë ligjet e moshës së pëlqimit dhe të angazhohen në vetëlëndim. Character.AI tani është përfshirë në një proces gjyqësor për të zbuluar nëse mund të mbahet përgjegjës për vdekjen e një 14-vjeçari nga vetëvrasja. Dhe nëse ai studim që përmenda më herët është i drejtë, kujtdo që përdor AI është degraduar mendimin e tij kritik – kështu që ata mund të jenë më pak në gjendje t’i rezistojnë sugjerimeve të këqija të AI.

Nëse do të isha në mëdyshje për një pyetje etike, mund të flisja me kolegët e mi, ose të takoja miqtë e mi në një bar për ta hasur atë, ose të marr punën e një filozofi që respektoj. Por unë jam edhe një grua e moshës së mesme që kam menduar për etikën prej dekadash dhe kam fatin që kam shumë miq. Nëse do të isha një adoleshent i vetmuar dhe do t’i bëja një chatbot një pyetje të tillë, çfarë mund të bëja me përgjigjen? Si mund të ndikohesha nga përgjigja nëse besoja se AI-të ishin më të zgjuar se unë? A do t’i zbatoja ato rezultate në botën reale?

Në fakt, përshtypja dërrmuese që kam nga mjetet gjeneruese të AI është se ato janë krijuar nga njerëz që nuk kuptojnë se si të mendojnë dhe do të preferonin të mos e bënin këtë. Fakti që zhvilluesit nuk e kanë izoluar mendimin etik këtu, rrjedh me pamendueshmërinë e përgjithshme të të gjithë projektit OpenAI.

Ideologjia pas AI mund të mendohet më së miri si antihumanizëm i pakujdesshëm. Nga sjellja e industrisë së AI – thithja e çdo vepre shkrimi dhe arti në internet për të ofruar të dhëna trajnimi – është e mundur të nxirret qëndrimi i saj ndaj punës humaniste: është i parëndësishëm, i padenjë për respekt dhe zëvendësohet lehtësisht nga prodhimi i makinës.

Grok, ChatGPT dhe Gemini tregtohen si pajisje “që kursejnë kohë” që synojnë të më kursejnë punën e të shkruarit dhe të menduarit. Por unë nuk dua t’i shmang ato gjëra. Të shkruarit është të menduarit, dhe të menduarit është një pjesë e rëndësishme e ndjekjes së jetës së mirë. Leximi është gjithashtu të menduarit, dhe një lloj i mrekullueshëm. Leximi i shkrimeve të dikujt tjetër është një nga mënyrat e vetme se si mund të zbulojmë se si është të jesh dikush tjetër. Ndërsa lexoni këto fjali, po mendoni mendimet e mia aktuale. (Intime, jo?) Ne madje mund të udhëtojmë në kohë duke e bërë këtë – Iris Murdoch mund të ketë vdekur, por Sovraniteti i së Mirës nuk është. Platoni ka vdekur për mijëvjeçarë, dhe megjithatë puna e tij është ende shoqëri e zgjuar. Kanti – mirë, sa më pak të thuhet për stilin e paimitueshëm të prozës së Kantit, aq më mirë.

Lëreni mënjanë gjithçka tjetër që AI mund ose nuk mund të bëjë. Të mendosh për etikën tënde – për mënyrën se si të jetosh – është ajo lloj gjëje që nuk mund dhe nuk duhet të jepet jashtë. Dokumentacioni ChatGPT sugjeron se kompania dëshiron që njerëzit të mbështeten në teknologjinë e tyre jo të besueshme për pyetje etike, gjë që është në vetvete një shenjë e keqe. Sigurisht, për të huazuar një mendim nga Upton Sinclair, është e vështirë të bësh një inxhinier të AI të kuptojë se po marrin një vendim të keq kur paga e tyre varet nga marrja e këtij vendimi.