CEO i Nvidia thotë se çipat e tij të AI po përmirësohen më shpejt se ligji i Moore

CEO i Nvidia, Jensen Huang thotë se performanca e çipave të inteligjencës artificiale të kompanisë së tij po përparon më shpejt se normat historike të përcaktuara nga Ligji i Moore, rubrika që nxiti përparimin e informatikës për dekada.

“Sistemet tona po përparojnë shumë më shpejt se ligji i Moore,” tha Huang në një intervistë me TechCrunch të martën, mëngjesin pasi ai mbajti një fjalim kryesor para një turme prej 10,000 personash në CES në Las Vegas.

I krijuar nga bashkëthemeluesi i Intel, Gordon Moore në vitin 1965, Ligji i Moore parashikoi se numri i transistorëve në çipat kompjuterikë do të dyfishohej afërsisht çdo dy vjet, duke dyfishuar në thelb performancën e atyre çipave. Ky parashikim kryesisht u shtri dhe krijoi përparime të shpejta në aftësi dhe ulje të kostove për dekada.

Vitet e fundit, Ligji i Moores është ngadalësuar. Megjithatë, Huang pretendon se çipat e AI të Nvidia po lëvizin me një ritëm të përshpejtuar të tyre; Kompania thotë se superçipi i saj i fundit i qendrës së të dhënave është më shumë se 30 herë më i shpejtë për ekzekutimin e ngarkesave të punës së konkluzioneve të AI sesa gjenerata e mëparshme.

“Ne mund të ndërtojmë arkitekturën, çipin, sistemin, bibliotekat dhe algoritmet të gjitha në të njëjtën kohë,” tha Huang. “Nëse e bëni këtë, atëherë mund të ecni më shpejt se Ligji i Moores, sepse mund të inovoni në të gjithë pirgun.”

Pretendimi i guximshëm nga CEO i Nvidia vjen në një kohë kur shumë po pyesin nëse përparimi i AI ka ngecur. Laboratorët kryesorë të AI – si Google, OpenAI dhe Anthropic – përdorin çipat e AI të Nvidia për të trajnuar dhe drejtuar modelet e tyre të AI, dhe përparimet në këto çipa ka të ngjarë të përkthehen në përparim të mëtejshëm në aftësitë e modeleve të AI.

Kjo nuk është hera e parë që Huang sugjeron se Nvidia po tejkalon ligjin e Moore. Në një podcast në nëntor, Huang sugjeroi se bota e AI është në ritmin e “Ligjit të hiper Moore”.

Huang kundërshton idenë se përparimi i AI po ngadalësohet. Në vend të kësaj ai pretendon se tani ekzistojnë tre ligje aktive për shkallëzimin e AI: para-trajnimi, faza fillestare e trajnimit ku modelet e AI mësojnë modele nga sasi të mëdha të dhënash; pas trajnimit, i cili rregullon përgjigjet e një modeli të AI duke përdorur metoda të tilla si reagimet njerëzore; dhe llogaritja e kohës së testimit, e cila ndodh gjatë fazës së përfundimit dhe i jep një modeli të AI më shumë kohë për të “menduar” pas çdo pyetjeje.

“Ligji i Moores ishte kaq i rëndësishëm në historinë e informatikës sepse uli kostot e llogaritjes,” tha Huang për TechCrunch. “E njëjta gjë do të ndodhë me konkluzionet ku ne rrisim performancën, dhe si rezultat, kostoja e konkluzionit do të jetë më e vogël.”

(Sigurisht, Nvidia është bërë kompania më e vlefshme në Tokë duke ecur në bumin e inteligjencës artificiale, kështu që Huang e bën dobi ta thotë këtë.)

H100-të e Nvidia ishin çipi i zgjedhur për kompanitë e teknologjisë që kërkonin të trajnojnë modele të AI, por tani që kompanitë e teknologjisë po fokusohen më shumë në konkluzionet, disa kanë vënë në pikëpyetje nëse çipat e shtrenjtë të Nvidia do të qëndrojnë ende në krye.

Modelet e AI që përdorin llogaritjen e kohës së testimit janë të shtrenjta për t’u ekzekutuar sot. Ekziston shqetësimi se modeli o3 i OpenAI, i cili përdor një version të shkallëzuar të llogaritjes së kohës së testimit, do të ishte shumë i shtrenjtë për shumicën e njerëzve për t’u përdorur. Për shembull, OpenAI shpenzoi gati 20 dollarë për detyrë duke përdorur o3 për të arritur rezultate të nivelit njerëzor në një test të inteligjencës së përgjithshme. Një abonim ChatGPT Plus kushton 20 dollarë për një muaj të tërë përdorimi.

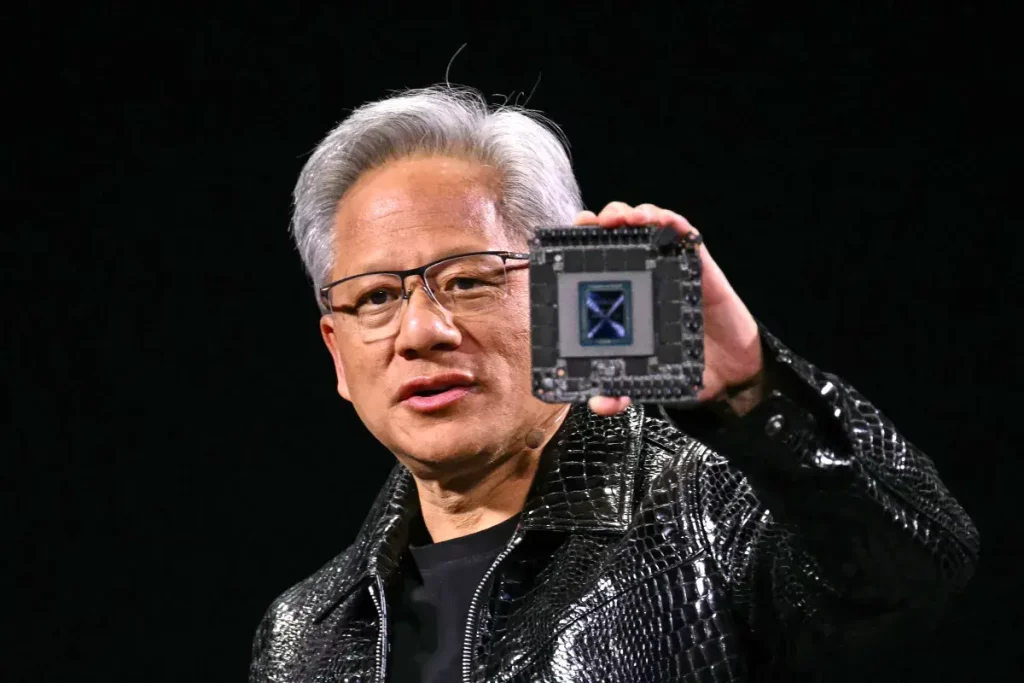

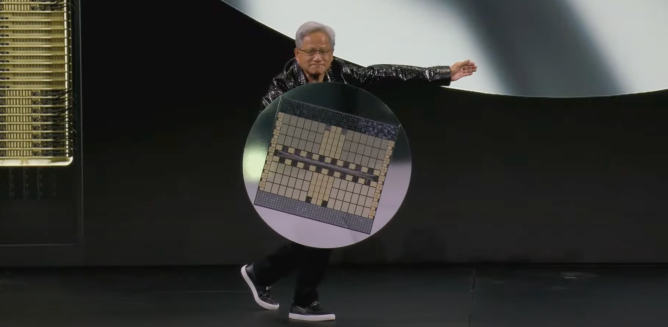

Huang mbajti superçipin më të fundit të qendrës së të dhënave të Nvidia, GB200 NVL72, në skenë si një mburojë gjatë fjalimit kryesor të së hënës. Ky çip është 30 deri në 40 herë më i shpejtë në ekzekutimin e ngarkesave të punës së konkluzioneve të AI sesa çipat e mëparshëm më të shitur të Nvidia, H100. Huang thotë se kjo rritje e performancës do të thotë që modelet e arsyetimit të AI si o3 i OpenAI, i cili përdor një sasi të konsiderueshme llogaritjeje gjatë fazës së përfundimit, do të bëhen më të lira me kalimin e kohës.

Huang thotë se në përgjithësi është i fokusuar në krijimin e çipave më performancë dhe se çipat më performues krijojnë çmime më të ulëta në afat të gjatë.

“Zgjidhja e drejtpërdrejtë dhe e menjëhershme për llogaritjen në kohë testimi, si në performancë ashtu edhe në përballueshmërinë e kostos, është të rrisim aftësinë tonë informatike,” tha Huang për TechCrunch. Ai vuri në dukje se në afat të gjatë, modelet e arsyetimit të AI mund të përdoren për të krijuar të dhëna më të mira për para-trajnimin dhe pas-trajnimin e modeleve të AI.

Sigurisht që kemi parë rënien e çmimit të modeleve të AI vitin e kaluar, pjesërisht për shkak të përparimeve kompjuterike nga kompanitë e harduerit si Nvidia. Huang thotë se ky është një trend që ai pret të vazhdojë me modelet e arsyetimit të AI, edhe pse versionet e para që kemi parë nga OpenAI kanë qenë mjaft të shtrenjta.

Më gjerësisht, Huang pretendoi se çipat e tij të inteligjencës artificiale sot janë 1000 herë më të mira se sa ajo që prodhoi 10 vjet më parë. Ky është një ritëm shumë më i shpejtë se standardi i vendosur nga Ligji i Moores, një Huang thotë se nuk sheh asnjë shenjë të ndalimit së shpejti.