Google Gemini 2.0 Flash del me bisedë në kohë reale, analizë imazhi

Google lëshoi të mërkurën Gemini 2.0 Flash, shtesën më të fundit në linjën e modeleve të tij të AI, me shpresën që zhvilluesit do të krijojnë aplikacione agjentë në AI Studio dhe Vertex AI.

Agjentët e AI janë të gjithë bujë për momentin midis prodhuesve të modeleve të mësimit të makinerisë, sepse ekziston një treg i supozuar për punë që rrjedh nga softueri që është i aftë, i pajtueshëm dhe i lirë – cilësi që ende nuk janë të dukshme në modelet aktuale të AI.

Agjentët e AI përbëhen nga modele të AI që mund të kryejnë detyra me shumë hapa, siç drejtohen nga kërkesa komplekse, përgjithësisht në lidhje me burimet dhe mjetet e jashtme të të dhënave. Fjala për aksionarët e firmave të fokusuara në AI shkon diçka e tillë: klientët do të jenë në gjendje t’i kërkojnë agjentit tonë të AI të planifikojë një pushim dhe – të fusë këtu strategjinë e fitimit të parave – agjenti në fakt do të ekzekutojë hapat e ndryshëm të kërkuar, duke përfshirë bërjen e rezervimeve dhe pagesën për transport.

Nuk jemi ende atje sepse shumica e njerëzve nuk janë gati të delegojnë autoritetin e blerjes ose aksesin e plotë të aplikacionit në modele jo të besueshme të AI. Por shpresa është që shqetësime të tilla mund të adresohen deri në atë pikë sa njerëzit të jenë të gatshëm ta provojnë. Dhe duke pasur parasysh tolerancën e demonstruar të publikut ndaj rrezikut për investimet në kriptomonedha dhe drejtimin e automatizuar pa duar, kjo pikë nuk është larg.

“Zbatimi praktik i agjentëve të AI është një zonë kërkimore plot me mundësi emocionuese,” tha Demis Hassabis, CEO i Google DeepMind dhe Koray Kavukcuoglu, CTO i Google DeepMind, në një njoftim të dhënë më herët për The Register.

“Ne jemi duke eksploruar këtë kufi të ri me një seri prototipash që mund t’i ndihmojnë njerëzit të përmbushin detyrat dhe të kryejnë gjërat. Këto përfshijnë një përditësim të Projektit Astra, prototipi ynë i kërkimit që eksploron aftësitë e ardhshme të një asistenti universal të AI; Projekti i ri Mariner, i cili eksploron të ardhmen e ndërveprimit njeri-agjent, duke filluar me shfletuesin tuaj dhe Jules, një agjent kodi me AI që mund të ndihmojë zhvilluesit.”

Për të realizuar ëndrrat e tij për Jarvis – një referencë për asistentin personal të përshkruar në filmat e Marvel’s Iron Man – Google po synon zhvilluesit e softuerit. Nëpërmjet platformave të tij AI Studio dhe Vertex AI, biz po ofron modele të AI që mund të bazohen – të lidhen me burime specifike të dhënash për t’i bërë përgjigjet e modeleve më të sakta – dhe t’u jepet akses në funksione dhe mjete specifike.

“AI Studio është me të vërtetë synuar të jetë një lloj ndërfaqe për zhvilluesit që të kenë akses në modelet më të fundit të Google,” shpjegoi Logan Kilpatrick, menaxher produkti për AI Studio dhe Gemini API, gjatë një konferencë për media. “Ju keni të gjitha ato lloje të modeleve eksperimentale që kemi lëshuar atje. Ju keni të gjitha modelet e prodhimit. Qëllimi është që t’ju interesojë për aftësitë që Gemini ka për të ofruar dhe më pas në fund t’ju bëjë të ndërtoni me Gemini API dhe në fakt si duke e vendosur Binjakët në aplikacionet dhe projektet tuaja.”

Gemini 2.0 Flash vjen një vit pas debutimit të modelit të parë Gemini të Google. Ai i bashkohet një formacioni që përfshin modele të tjera të familjes Gemini: Gemini 1.0 Ultra, Gemini 1.5 Pro, Gemini 1.0 Pro dhe Gemini 1.5 Flash dhe Gemini 1.0 Nano.

Në përgjithësi, versionet 1.5 janë më të afta se versionet 1.0 dhe modelet më të mëdha priren të performojnë më mirë se ato më të voglat (Ultra, Pro, Flash dhe Nano, sipas madhësisë); Fabrika e Çokollatës ka publikuar standarde që japin më shumë detaje. Gemini 2.0 Flash thuhet se është dy herë më i shpejtë se 1.5 Pro, me performancë më të mirë.

Gemini 2.0 Flash sjell disa aftësi të reja në tryezë. Modeli është shumëgjuhësh dhe gjithashtu multimodal – ai mund të pranojë tekst, imazhe dhe audio si hyrje dhe mund të përgjigjet në cilindo nga ato mënyra. Dhe ka një API të drejtpërdrejtë multimodale – kështu që mund të përfshihet në biseda në kohë reale dhe analiza imazhi.

Plus, modeli i ri mbështet përdorimin e mjeteve, në formën e ekzekutimit dhe kërkimit të kodit, i cili siguron akses në informacionin e fundit, aftësitë e llogaritjes dhe aftësinë për të ndërvepruar me burimet e të dhënave pa konfigurim shtesë.

“Modeli tani është në gjendje të nxjerrë si audio ashtu edhe imazhe, të cilat do të fillojnë në një program me akses të hershëm, por do të shpërndahen më gjerësisht gjatë muajve të ardhshëm,” tha Kilpatrick.

Në lidhje me debutimin e Gemini 2.0 Flash, Google ka filluar të nxjerrë Jules, duke shtuar disa “aftësi të shkencës së të dhënave” në Google Colab dhe duke e bërë modelin e tij të ri të disponueshëm brenda Gemini Code Assist, zgjerimi i kodimit të AI të kompanisë për VS Code. IntelliJ PyCharm dhe IDE të tjera.

“Duke filluar nga sot [për testuesit e besuar], ju mund të shkarkoni detyrat e kodimit të Python dhe JavaScript te Jules, një agjent eksperimental i kodit me AI që do të përdorë Gemini 2.0,” tha Shrestha Basu Mallick, menaxhere e produkteve të grupit për Gemini API dhe Kathy Korevec. drejtor i produktit për Google Labs, në një njoftim të dhënë më herët për The Register.

“Duke punuar në mënyrë asinkrone dhe të integruar me rrjedhën tuaj të punës në GitHub, Jules trajton korrigjimet e gabimeve dhe detyra të tjera që kërkojnë kohë, ndërsa përqendroheni në atë që dëshironi të ndërtoni në të vërtetë.”

Ata që nuk janë në programin e testuesit të besuar mund të regjistrohen për të provuar Jules në 2025.

Si një demonstrim i Gemini 2.0 Flash, Basu Mallick luajti një lojë prej 20 pyetjesh me modelen duke folur me të dhe duke dëgjuar përgjigjet e saj. Ajo gjithashtu i kërkoi të numëronte numrin e gishtërinjve që mbante lart në një transmetim video dhe të thoshte se çfarë ngjyre ishin lyer thonjtë e saj. Modelja u përgjigj në mënyrë adekuate në të dyja rastet, megjithëse ne do të argumentonim se “e kuqe” do të kishte qenë një përgjigje më e saktë për pyetjen e ngjyrës së thonjve sesa “rozë”. Sidoqoftë, kjo thjesht mund të pasqyrojë ndryshimet në paraqitjen e ngjyrave të monitorit.

Basu Mallick demonstroi gjithashtu se si Gemini 2.0 Flash mund të trajtojë një kërkesë me shumë hapa duke i kërkuar modelit të identifikojë pesë filmat më të gjatë nga Denis Villeneuve, të llogarisë kohën e tyre përkatëse të ekzekutimit dhe më pas të paraqesë të dhënat në një grafik. Detyra përfshinte që modeli të gjeneronte kodin Python dhe ta ekzekutonte atë në një sandbox për të llogaritur rezultatet.

“Ky është lloji i kërkesës komplekse ku së pari duhet të zgjidhni pjesën e parë të kërkesës dhe më pas pjesën e dytë të kërkesës,” shpjegoi ajo. “Pastaj po i kërkoj të shkruajë një kod për të gjetur se cili ka kohëzgjatjen më të gjatë dhe më të shkurtër dhe më pas të bëjë një komplot.”

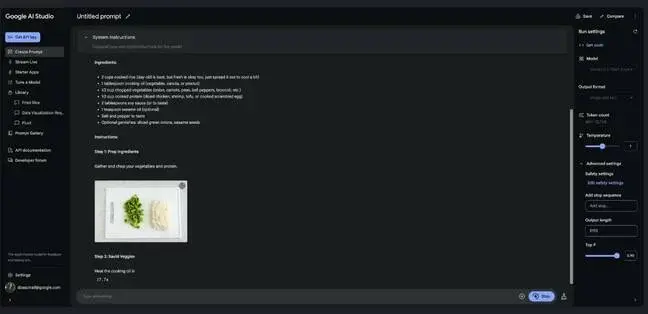

Një tjetër demonstrim tregoi aftësitë multimodale të Gemini 2.0 Flash për gjenerimin e recetave. Modeli ishte në gjendje të krijonte pamje vizuale që tregonin se si mund të duken përbërësit në një tigan për të shtuar udhëzimet e tekstit të krijuara.

E vetmja gjë që mungonte ishte informacioni i çmimit. “Ne nuk po themi vërtet çmimet në këtë kohë,” tha Kilpatrick. “Zhvilluesit do të jenë në gjendje të përdorin API multimodal live dhe modelet 2.0 falas përmes studios AI, dhe kur të bëjmë një lëshim më të gjerë në fillim të vitit të ardhshëm, ne do të ndjekim çmimet.”