Intel dhe të tjerët angazhohen për të ndërtuar mjete të hapura gjeneruese të AI për ndërmarrjen

A mund të jetë ndonjëherë e ndërveprueshme AI gjeneruese e krijuar për ndërmarrjen (për shembull, AI që plotëson automatikisht raportet, formulat e tabelave dhe kështu me radhë)? Së bashku me një sërë organizatash përfshirë Cloudera dhe Intel, Fondacioni Linux – organizata jofitimprurëse që mbështet dhe mban një numër në rritje të përpjekjeve me burim të hapur – synon të zbulojë.

Fondacioni Linux njoftoi të martën lançimin e Platformës së Hapur për AI të Ndërmarrjeve (OPEA), një projekt për të nxitur zhvillimin e sistemeve të AI gjeneruese të hapura, me shumë ofrues dhe të kompozueshëm (dmth modular). Nën kompetencën e LF AI dhe org të të dhënave të Fondacionit Linux, i cili përqendrohet në iniciativat e platformave të lidhura me AI dhe të dhënat, qëllimi i OPEA do të jetë të hapë rrugën për lëshimin e sistemeve gjeneruese të AI “të ngurtësuar”, “të shkallëzuar” që “shfrytëzojnë inovacioni më i mirë me burim të hapur nga i gjithë ekosistemi,” tha në një deklaratë për shtyp drejtori ekzekutiv i LF AI dhe Data, Ibrahim Haddad.

“OPEA do të zhbllokojë mundësi të reja në AI duke krijuar një kornizë të detajuar dhe të përbërë që qëndron në ballë të grupeve të teknologjisë,” tha Haddad. “Kjo nismë është një testament për misionin tonë për të nxitur inovacionin dhe bashkëpunimin me burim të hapur brenda AI dhe komuniteteve të të dhënave nën një model qeverisjeje neutrale dhe të hapur.”

Përveç Cloudera-s dhe Intel-it, OPEA – një nga projektet Sandbox të Fondacionit Linux, një lloj programi inkubator – numëron ndër anëtarët e tij peshat e rënda të ndërmarrjeve si Intel, Red Hat në pronësi të IBM, Hugging Face, Domino Data Lab, MariaDB dhe VMware.

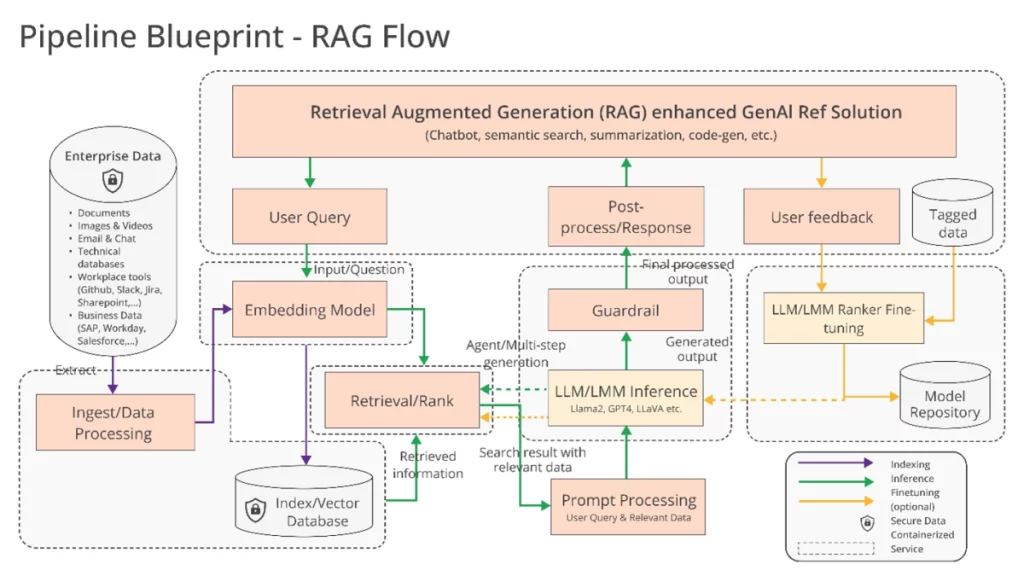

Pra, çfarë mund të ndërtojnë saktësisht së bashku? Haddad lë të kuptohet për disa mundësi, të tilla si mbështetja “e optimizuar” për zinxhirët e mjeteve dhe përpiluesit e AI, të cilat mundësojnë që ngarkesat e punës të AI të kalojnë nëpër komponentë të ndryshëm harduerikë, si dhe tubacione “heterogjene” për gjenerimin e shtuar me rikthim (RAG).

RAG po bëhet gjithnjë e më popullor në aplikacionet e ndërmarrjeve të AI gjeneruese dhe nuk është e vështirë të kuptosh pse. Shumica e përgjigjeve dhe veprimeve të modeleve gjeneruese të AI janë të kufizuara në të dhënat mbi të cilat ata janë trajnuar. Por me RAG, baza e njohurive të një modeli mund të zgjerohet në informacione jashtë të dhënave origjinale të trajnimit. Modelet RAG i referohen këtij informacioni të jashtëm – i cili mund të marrë formën e të dhënave pronësore të kompanisë, një bazë të dhënash publike ose një kombinim të të dyjave – përpara se të gjenerojnë një përgjigje ose të kryejnë një detyrë.

Intel ofroi disa detaje të tjera në njoftimin e vet për shtyp :

Ndërmarrjet sfidohen me një qasje të bërë vetë [për RAG] sepse nuk ka standarde de fakto në të gjithë komponentët që i lejojnë ndërmarrjet të zgjedhin dhe të vendosin zgjidhje RAG që janë të hapura dhe të ndërveprueshme dhe që i ndihmojnë ato të dalin shpejt në treg. OPEA synon t’i adresojë këto çështje duke bashkëpunuar me industrinë për të standardizuar komponentët, duke përfshirë kornizat, planet e arkitekturës dhe zgjidhjet e referencës.

Vlerësimi do të jetë gjithashtu një pjesë kyçe e asaj që trajton OPEA.

Në depon e saj GitHub , OPEA propozon një rubrikë për klasifikimin e sistemeve gjeneruese të AI përgjatë katër akseve: performancën, veçoritë, besueshmërinë dhe gatishmërinë “e shkallës së sipërmarrjes”. Performanca siç e përcakton OPEA ka të bëjë me standardet e “kutisë së zezë” nga rastet e përdorimit të botës reale. Karakteristikat janë një vlerësim i ndërveprueshmërisë së një sistemi, zgjedhjeve të vendosjes dhe lehtësisë së përdorimit. Besueshmëria shikon aftësinë e një modeli të AI për të garantuar “fortësi” dhe cilësi. Dhe gatishmëria e ndërmarrjes përqendrohet në kërkesat për të vënë në funksion një sistem pa probleme madhore.

Rachel Roumeliotis, drejtore e strategjisë me burim të hapur në Intel, thotë se OPEA do të punojë me komunitetin me burim të hapur për të ofruar teste të bazuara në rubrikë, si dhe për të ofruar vlerësime dhe klasifikime të vendosjeve gjeneruese të AI sipas kërkesës.

Përpjekjet e tjera të OPEA janë pak në ajër për momentin. Por Haddad përhapi potencialin e zhvillimit të modelit të hapur përgjatë linjave të familjes Llama në zgjerim të Metës dhe DBRX të Databricks . Për këtë qëllim, në repon e OPEA, Intel ka kontribuar tashmë me implementime referimi për një chatbot gjenerues me AI, përmbledhës dokumentesh dhe gjenerues kodesh të optimizuar për harduerin e tij Xeon 6 dhe Gaudi 2.

Tani, anëtarët e OPEA janë shumë të qartë të investuar (dhe me interesa personale, për këtë çështje) në ndërtimin e mjeteve për AI gjeneruese të ndërmarrjeve. Cloudera lançoi së fundmi partneritete për të krijuar atë që po paraqet si një “ekosistem AI” në re. Domino ofron një sërë aplikacionesh për ndërtimin dhe auditimin e AI gjeneruese të biznesit. Dhe VMware – e orientuar drejt anës së infrastrukturës së AI të ndërmarrjes – gushtin e kaluar nxori produkte të reja kompjuterike “private AI”.

Pyetja është nëse këta shitës do të punojnë së bashku për të ndërtuar mjete të ndër-përputhshme të AI nën OPEA.

Ka një përfitim të dukshëm për ta bërë këtë. Klientët me kënaqësi do të tërheqin shitës të shumtë në varësi të nevojave, burimeve dhe buxheteve të tyre. Por historia ka treguar se është shumë e lehtë të bëhesh i prirur drejt mbylljes së shitësve. Le të shpresojmë se ky nuk është rezultati përfundimtar këtu.