Mikroskopi i AI i Anthropic zbulon se si Claude planifikon paraprakisht kur gjeneron poezi

“Mikroskopi i ri AI” i Anthropic ofron një pamje të kufizuar në paraqitjet e brendshme të modelit të gjuhës Haiku Claude 3.5, duke zbuluar se si ai përpunon informacionin dhe arsyet përmes detyrave komplekse.

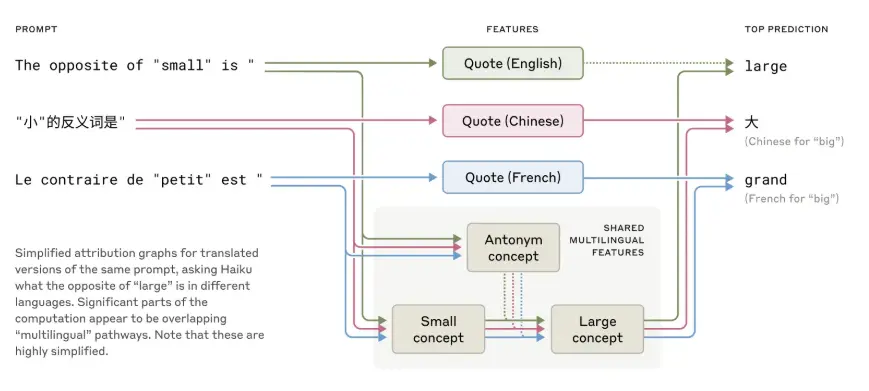

Një gjetje kryesore, sipas Anthropic, është se Claude duket se përdor një lloj përfaqësimi të brendshëm të pavarur nga gjuha – atë që studiuesit e quajnë “gjuhë universale të mendimit”. Për shembull, kur kërkohet të gjenerojë të kundërtën e fjalës “i vogël” në shumë gjuhë, modeli fillimisht aktivizon një koncept të përbashkët përpara se të nxjerrë përgjigjen e përkthyer në gjuhën e synuar.

Anthropic raporton se modelet më të mëdha si Claude 3.5 shfaqin mbivendosje më të madhe konceptuale nëpër gjuhë sesa modelet më të vogla. Sipas studiuesve, ky përfaqësim abstrakt mund të mbështesë një arsyetim shumëgjuhësh më të qëndrueshëm.

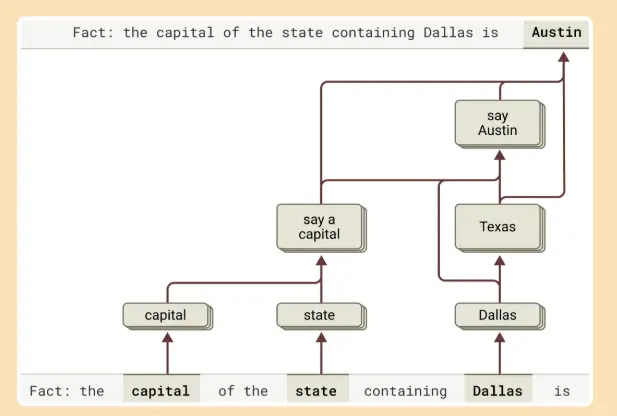

Hulumtimi shqyrtoi gjithashtu përgjigjen e Claude ndaj pyetjeve që kërkojnë hapa të shumëfishtë arsyetimi, të tilla si: “Cili është kryeqyteti i shtetit në të cilin ndodhet Dallas?” Sipas Anthropic, modeli aktivizon përfaqësimet për “Dallas është në Teksas” dhe më pas e lidh atë me “kryeqytetin e Teksasit është Austin”. Kjo sekuencë tregon se Claude nuk po kujton thjesht faktet, por po kryen përfundime me shumë hapa.

Studiuesit zbuluan gjithashtu se Claude planifikon disa fjalë paraprakisht kur gjeneron poezi. Në vend që të kompozojë rresht pas rreshti, ai fillon duke zgjedhur fjalët e përshtatshme të rimuara, pastaj ndërton çdo rresht për të çuar drejt atyre objektivave. Nëse fjalët e synuara ndryshojnë, modeli prodhon një poezi krejtësisht të ndryshme – një tregues i planifikimit të qëllimshëm dhe jo parashikimi i thjeshtë fjalë për fjalë.

Për detyrat matematikore, Claude përdor shtigje përpunimi paralel – një për përafrim dhe një tjetër për llogaritjen e saktë. Megjithatë, kur nxitet të shpjegojë arsyetimin e tij, Claude përshkruan një proces të ndryshëm nga ai që përdori në të vërtetë – duke sugjeruar se po imiton shpjegime të ngjashme me njeriun në vend që të raportojë me saktësi logjikën e tij të brendshme. Studiuesit gjithashtu vërejnë se kur jepet një sugjerim i gabuar, Claude shpesh gjeneron një shpjegim koherent që është logjikisht i pasaktë.

Hulumtimi nga Google ofron një linjë paralele hetimi. Një studim i fundit i botuar në Nature Human Behavior analizoi ngjashmëritë midis modeleve të gjuhës së AI dhe aktivitetit të trurit të njeriut gjatë bisedës. Ekipi i Google zbuloi se përfaqësimet e brendshme nga modeli Whisper i OpenAI përputheshin ngushtë me modelet e aktivitetit nervor të regjistruara nga subjektet njerëzore. Në të dyja rastet, sistemet dukej se parashikonin fjalët e ardhshme përpara se ato të thuheshin.

Pavarësisht këtyre ngjashmërive, studiuesit theksojnë dallimet thelbësore midis dy sistemeve. Ndryshe nga modelet Transformer, të cilat mund të përpunojnë qindra ose mijëra argumente njëkohësisht, truri i njeriut përpunon gjuhën në mënyrë sekuenciale – fjalë për fjalë, me kalimin e kohës dhe me sythe të përsëritura. Google shkruan, ” Ndërsa truri i njeriut dhe LLM-të e bazuara në Transformer ndajnë parimet bazë llogaritëse në përpunimin e gjuhës natyrore, arkitekturat e tyre themelore të qarkut nervor ndryshojnë ndjeshëm.”