Modeli i fundit i Mistral vendos rekorde të reja për LLM-të me burim të hapur

Fillesa franceze e inteligjencës artificiale Mistral AI ka zbuluar Mixtral 8x22B, një model të ri të gjuhës me burim të hapur që kompania pretendon se arrin performancën dhe efikasitetin më të lartë të burimit të hapur.

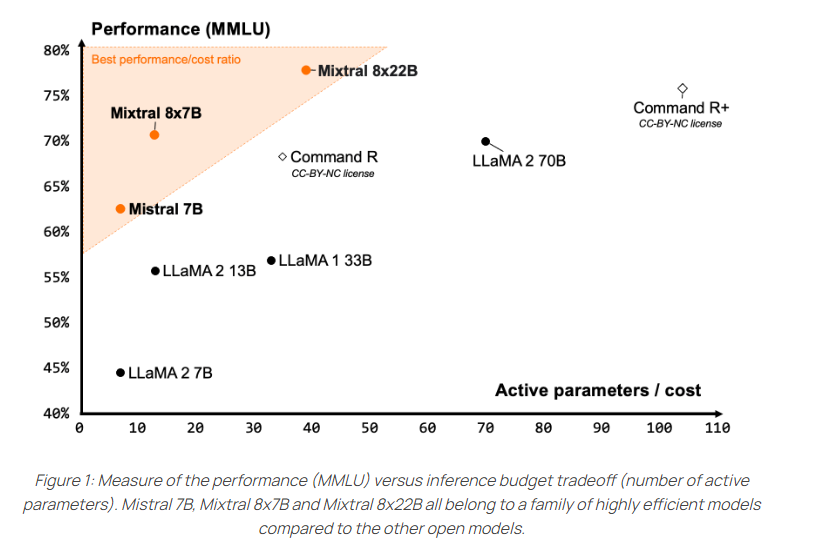

Modeli është një model i rrallë i përzierjes së ekspertëve (SMoE) që përdor në mënyrë aktive vetëm 39 miliardë nga 141 miliardë parametrat e tij. Si rezultat, ekipi i zhvillimit pretendon se ofron një raport jashtëzakonisht të mirë çmim/performancë për madhësinë e tij. Paraardhësi i tij, Mixtral 8x7B, është pritur mirë nga komuniteti me burim të hapur.

Sipas Mistral, pikat e forta të Mixtral 8x22B përfshijnë shumëgjuhësinë, me mbështetje për anglisht, frëngjisht, italisht, gjermanisht dhe spanjisht, si dhe aftësi të forta matematikore dhe programimi. Ai gjithashtu ofron funksionin vendas që thërret për përdorimin e mjeteve të jashtme. Me 64,000 argumente, dritarja e kontekstit është më e vogël se ajo e modeleve kryesore tregtare aktuale si GPT-4 (128K) ose Claude 3 (200K).

Ekipi Mistral lëshon Mixtral 8x22B nën licencën Apache 2.0, licenca më lejuese e disponueshme me burim të hapur. Ai lejon përdorimin e pakufizuar të modelit.

Sipas Mistral, përdorimi i rrallë i modelit të parametrave aktivë e bën atë më të shpejtë se modelet tradicionale me 70 miliardë parametra të trajnuar dendur dhe më të aftë se modelet e tjera me burim të hapur.

Krahasuar me modelet e tjera të hapura, Mixtral 8x22B arrin rezultatet më të mira në testet popullore të të kuptuarit, logjikës dhe njohurive si MMLU, HellaSwag, Wino Grande, Arc Challenge, TriviaQA dhe NaturalQS.

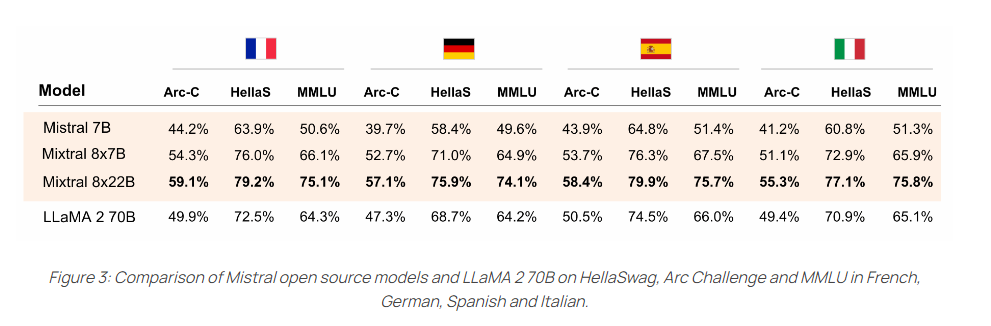

Ai gjithashtu tejkalon qartë modelin 70B LLaMA-2 në gjuhët e mbështetura – frëngjisht, gjermanisht, spanjisht dhe italisht – në standardet HellaSwag, Arc Challenge dhe MMLU.

Modeli i ri tani mund të testohet në “la Plateforme” të Mistral. Versioni me burim të hapur është i disponueshëm në Hugging Face dhe është një pikënisje e mirë për akordimin e aplikacioneve, sipas Mistral. Modeli kërkon 258 gigabajt VRAM.