OpenAI, Google dhe Anthropic po luftojnë për të ndërtuar AI më të avancuar

OpenAI ishte në majë të një momenti historik. Fillimi përfundoi një raund fillestar trajnimi në shtator për një model të ri masiv të inteligjencës artificiale që shpresonte se do të kalonte ndjeshëm versionet e mëparshme të teknologjisë pas ChatGPT dhe do t’i afrohej qëllimit të tij për AI të fuqishme që i kalon njerëzit.

Por modeli, i njohur nga brenda si Orion, nuk arriti performancën e dëshiruar të kompanisë, sipas dy personave të njohur me këtë çështje, të cilët folën në kushte anonimiteti për të diskutuar çështjet e kompanisë. Për shembull, nga fundi i verës, Orion dështoi kur u përpoq t’u përgjigjej pyetjeve të kodimit për të cilat nuk ishte trajnuar, thanë njerëzit. Në përgjithësi, Orion deri më tani nuk konsiderohet të jetë një hap aq i madh nga modelet ekzistuese të OpenAI-t sa GPT-4 ishte nga GPT-3.5, sistemi që fillimisht fuqizoi chatbot-in kryesor të kompanisë, thanë njerëzit.

OpenAI nuk është i vetmi në goditjen e pengesave kohët e fundit. Pas viteve të nxjerrjes së produkteve gjithnjë e më të sofistikuara të inteligjencës artificiale me një ritëm marramendës, tre nga kompanitë kryesore të AI tani po shohin kthime në rënie nga përpjekjet e tyre të kushtueshme për të ndërtuar modele më të reja. Në Google të Alphabet Inc., një përsëritje e ardhshme e softuerit të saj Gemini nuk po i plotëson pritshmëritë e brendshme, sipas tre njerëzve me njohuri për këtë çështje. Ndërkohë, Anthropic e ka parë gabimin e orarit të lansimit të modelit të saj të shumëpritur Claude të quajtur 3.5 Opus.

Kompanitë po përballen me disa sfida. Është bërë gjithnjë e më e vështirë gjetja e burimeve të reja, të pashfrytëzuara të të dhënave të trajnimit me cilësi të lartë, të krijuara nga njeriu, që mund të përdoren për të ndërtuar sisteme më të avancuara të AI. Performanca e pakënaqshme e kodimit të Orion ishte pjesërisht për shkak të mungesës së të dhënave të mjaftueshme të kodimit për t’u trajnuar, thanë dy persona. Në të njëjtën kohë, edhe përmirësimet modeste mund të mos jenë të mjaftueshme për të justifikuar kostot e jashtëzakonshme që lidhen me ndërtimin dhe funksionimin e modeleve të reja, ose për të përmbushur pritshmëritë që vijnë nga markimi i një produkti si një përmirësim i madh.

Ka shumë potencial për t’i bërë këto modele më të mira. Sipas njërit prej njerëzve, OpenAI e ka vënë Orionin në një proces disamujor që shpesh quhet pas-trajnim. Kjo procedurë, e cila është rutinë përpara se një kompani të lëshojë publikisht softuerin e ri të AI, përfshin përfshirjen e reagimeve njerëzore për të përmirësuar përgjigjet dhe përsosjen e tonit për mënyrën se si modeli duhet të ndërveprojë me përdoruesit, ndër të tjera. Por Orion nuk është ende në nivelin që OpenAI do të dëshironte për ta lëshuar atë te përdoruesit dhe kompania nuk ka gjasa të nxjerrë sistemin deri në fillim të vitit të ardhshëm, tha një person.

Këto çështje sfidojnë ungjillin që ka zënë vend në Silicon Valley vitet e fundit, veçanërisht që kur OpenAI publikoi ChatGPT dy vjet më parë. Pjesa më e madhe e industrisë së teknologjisë ka vënë bast mbi të ashtuquajturat ligje të shkallëzimit që thonë se më shumë fuqi kompjuterike, të dhëna dhe modele më të mëdha në mënyrë të pashmangshme do të hapin rrugën për hapa më të mëdhenj përpara në fuqinë e AI.

Dëmtimet e fundit gjithashtu ngrenë dyshime në lidhje me investimet e mëdha në AI dhe mundësinë e arritjes së një qëllimi kryesor, këto kompani po ndjekin në mënyrë agresive inteligjencën e përgjithshme artificiale. Termi zakonisht i referohet sistemeve hipotetike të AI që do të përputheshin ose do të tejkalonin njerëzit në shumë detyra intelektuale. Shefat ekzekutivë të OpenAI dhe Anthropic kanë thënë më parë se AGI mund të jetë vetëm disa vite larg.

“Flluska AGI po shpërthen pak,” tha Margaret Mitchell, shkencëtare kryesore e etikës në startupin e inteligjencës artificiale Hugging Face. Është bërë e qartë, tha ajo, se “qasje të ndryshme trajnimi” mund të nevojiten për t’i bërë modelet e AI të funksionojnë vërtet mirë në një sërë detyrash – një ide që një numër ekspertësh në inteligjencën artificiale i bënë jehonë Bloomberg News.

Në një deklaratë, një zëdhënës i Google DeepMind tha se kompania është “e kënaqur me përparimin që po shohim në Gemini dhe ne do të ndajmë më shumë kur të jemi gati”. OpenAI nuk pranoi të komentonte. Anthropic nuk pranoi të komentojë, por i referoi Bloomberg News në një podcast pesë-orësh me shefin ekzekutiv Dario Amodei që u publikua të hënën.

“Njerëzit i quajnë ligje të shkallëzimit. Ky është një emërtim i gabuar,” tha ai në podcast. “Ato nuk janë ligje të universit. Ato janë rregullsi empirike. Unë do të vë bast në favor të tyre që të vazhdojnë, por nuk jam i sigurt për këtë.”

Amodei tha se ka “shumë gjëra” që mund të “ngatërrojnë” procesin e arritjes së AI më të fuqishme në vitet e ardhshme, duke përfshirë mundësinë që “mund të na mbarojnë të dhënat”. Por Amodei tha se ai është optimist që kompanitë e AI do të gjejnë një mënyrë për të kapërcyer çdo pengesë.

Teknologjia që mbështet ChatGPT dhe një valë të chatbot-ve rivalë të AI-së u ndërtua në një grumbull postimesh në media sociale, komente në internet, libra dhe të dhëna të tjera të grumbulluara lirisht nga i gjithë uebi. Kjo ishte e mjaftueshme për të krijuar produkte që mund të nxjerrin ese dhe poezi të zgjuara, por ndërtimi i sistemeve të AI që janë më të zgjuar se një laureat i Nobelit – siç shpresojnë disa kompani – mund të kërkojnë burime të dhënash të tjera përveç postimeve të Wikipedia dhe titrave në YouTube.

OpenAI, në veçanti, ka nënshkruar marrëveshje me botuesit për të plotësuar një pjesë të nevojës për të dhëna me cilësi të lartë, dhe gjithashtu për t’iu përshtatur presionit ligjor në rritje nga botuesit dhe artistët mbi të dhënat e përdorura për të ndërtuar produkte gjeneruese të AI. Disa kompani të teknologjisë po punësojnë gjithashtu njerëz me diploma të diplomuar që mund të etiketojnë të dhënat që lidhen me ekspertizën e tyre lëndore, si matematika dhe kodimi. Qëllimi është që këto sisteme të bëhen më të mira në përgjigjen ndaj pyetjeve rreth temave të caktuara.

Këto përpjekje janë më të ngadalta dhe më të kushtueshme sesa thjesht gërvishtja e rrjetit. Kompanitë e teknologjisë po i drejtohen gjithashtu të dhënave sintetike, të tilla si imazhet e krijuara nga kompjuteri ose teksti që synon të imitojë përmbajtjen e krijuar nga njerëz të vërtetë. Por edhe këtu ka kufizime.

“Ka të bëjë më pak për sasinë dhe më shumë për cilësinë dhe diversitetin e të dhënave,” tha Lila Tretikov, drejtuese e strategjisë së AI në New Enterprise Associates dhe ish-zëvendës shefe e teknologjisë në Microsoft. “Ne mund të gjenerojmë sasi në mënyrë sintetike, megjithatë ne luftojmë për të marrë grupe të dhënash unike, me cilësi të lartë pa udhëzim njerëzor, veçanërisht kur bëhet fjalë për gjuhën.”

Megjithatë, kompanitë e AI vazhdojnë të ndjekin një libër lojërash më shumë-është-më mirë. Në përpjekjen e tyre për të ndërtuar produkte që i afrohen nivelit të inteligjencës njerëzore, firmat e teknologjisë po rrisin sasinë e fuqisë kompjuterike, të dhënave dhe kohës që përdorin për të trajnuar modele të reja – dhe po rrisin kostot në proces. Amodei ka thënë se kompanitë do të shpenzojnë 100 milionë dollarë për të trajnuar një model të përgjakshëm këtë vit dhe kjo shumë do të arrijë në 100 miliardë dollarë në vitet e ardhshme.

Me rritjen e kostove, rriten edhe aksionet dhe pritshmëritë për çdo model të ri në zhvillim. Noah Giansiracusa, një profesor i asociuar i matematikës në Universitetin Bentley në Waltham, Massachusetts, tha se modelet e AI do të vazhdojnë të përmirësohen, por shkalla me të cilën do të ndodhë është e diskutueshme.

“Ne u emocionuam shumë për një periudhë të shkurtër progresi shumë të shpejtë,” tha ai. “Kjo thjesht nuk ishte e qëndrueshme.”

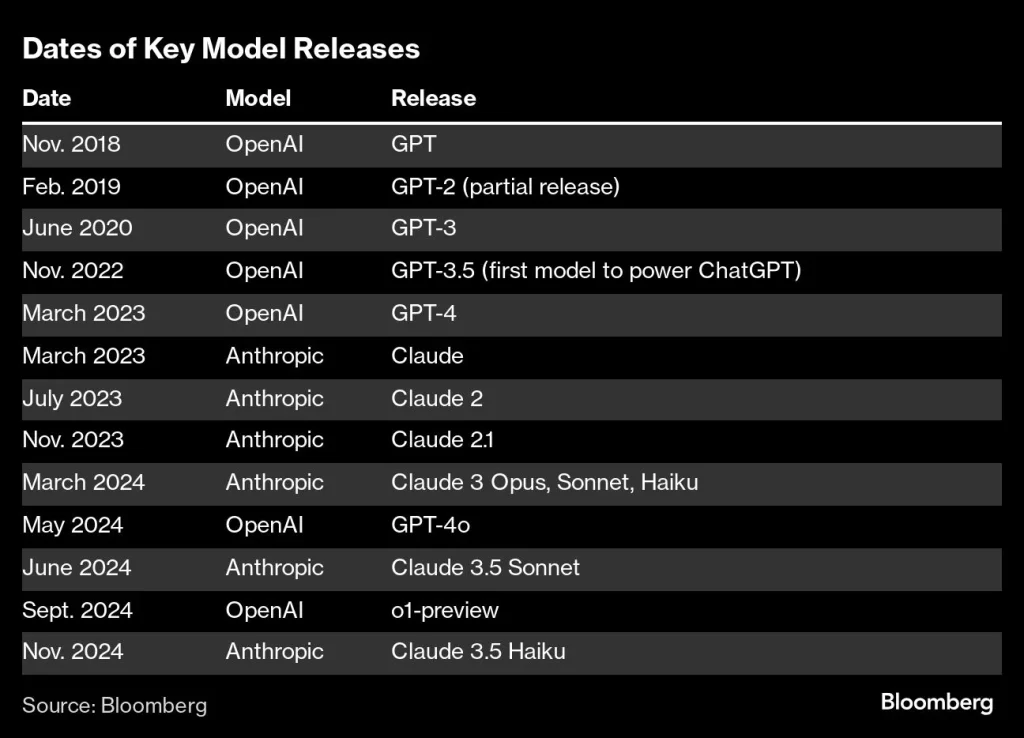

Ky rebus është vënë në fokus muajt e fundit brenda Silicon Valley. Në mars, Anthropic lëshoi një grup prej tre modelesh të reja dhe tha se opsioni më i fuqishëm, i quajtur Claude Opus, tejkaloi GPT-4 të OpenAI dhe sistemet Gemini të Google në standardet kryesore, të tilla si arsyetimi dhe kodimi i nivelit të diplomuar.

Gjatë muajve të ardhshëm, Anthropic nxori përditësime për dy modelet e tjera të Claude – por jo Opus. “Kjo ishte ajo për të cilën të gjithë ishin të emocionuar,” tha Simon Willison, një studiues i pavarur i AI. Deri në tetor, Willison dhe vëzhgues të tjerë të industrisë vunë re se formulimi në lidhje me 3.5 Opus, duke përfshirë një tregues se do të mbërrinte “më vonë këtë vit” dhe do të “vjen së shpejti”, u hoq nga disa faqe në faqen e internetit të kompanisë.

Ngjashëm me konkurrentët e tij, Anthropic është përballur me sfida në prapaskenë për të zhvilluar 3.5 Opus, sipas dy njerëzve të njohur me këtë çështje. Pas trajnimit të tij, Anthropic zbuloi se 3.5 Opus performoi më mirë në vlerësime sesa versioni më i vjetër, por jo aq sa duhet, duke pasur parasysh madhësinë e modelit dhe sa i kushtueshëm ishte ndërtimi dhe funksionimi, tha një nga njerëzit.

Një zëdhënës i Anthropic tha se gjuha për Opus u hoq nga faqja e internetit si pjesë e një vendimi marketingu për të shfaqur vetëm modelet e disponueshme dhe të krahasuara. I pyetur nëse Opus 3.5 do të dilte akoma këtë vit, zëdhënësi vuri në dukje komentet e podcast-it të Amodei. Në intervistë, CEO tha se Anthropic ende planifikon të nxjerrë modelin, por në mënyrë të përsëritur refuzoi të angazhohej për një orar.

Kompanitë e teknologjisë gjithashtu kanë filluar të luftojnë nëse do të vazhdojnë të ofrojnë modelet e tyre të vjetra të AI, ndoshta me disa përmirësime shtesë, ose të përballojnë kostot e mbështetjes së versioneve të reja jashtëzakonisht të shtrenjta që mund të mos performojnë shumë më mirë.

Google ka lëshuar përditësime për modelin e tij kryesor të AI Gemini për ta bërë atë më të dobishëm, duke përfshirë rivendosjen e aftësisë për të gjeneruar imazhe të njerëzve, por prezantoi disa përparime të mëdha në cilësinë e modelit themelor. OpenAI, ndërkohë, është përqendruar në një numër përditësimesh relativisht në rritje këtë vit, siç është një version i ri i një veçorie të asistentit zanor që lejon përdoruesit të kenë biseda më të qarta me ChatGPT.

Kohët e fundit, OpenAI nxori një version paraprak të një modeli të quajtur o1 që shpenzon kohë shtesë duke llogaritur një përgjigje përpara se t’i përgjigjet një pyetjeje, një proces që kompania i referohet si arsyetim. Google po punon në një qasje të ngjashme, me synimin për të trajtuar pyetje më komplekse dhe për të dhënë përgjigje më të mira me kalimin e kohës.

Firmat e teknologjisë gjithashtu përballen me kompromise domethënëse me devijimin e shumë burimeve të tyre të lakmuara kompjuterike drejt zhvillimit dhe përdorimit të modeleve më të mëdha që mund të mos jenë dukshëm më të mira.

“Të gjitha këto modele janë bërë mjaft komplekse dhe ne nuk mund të dërgojmë aq shumë gjëra paralelisht sa do të donim”, shkroi CEO i OpenAI, Sam Altman, në përgjigje të një pyetjeje në një sesion të fundit Ask Me Anything në Reddit. Prodhuesi i ChatGPT përballet me “shumë kufizime dhe vendime të vështira,” tha ai, në lidhje me mënyrën se si vendos se çfarë të bëjë me fuqinë e tij kompjuterike të disponueshme.

Altman tha se OpenAI do të ketë disa “lëshime shumë të mira” më vonë këtë vit, por kjo listë nuk do të përfshijë GPT-5 – një emër që shumë në industrinë e AI do të prisnin që kompania ta përdorë për një lëshim të madh pas GPT-4, i cili ishte prezantuar më shumë se 18 muaj më parë.

Ashtu si Google dhe Anthropic, OpenAI tani po e zhvendos vëmendjen nga madhësia e këtyre modeleve në rastet më të reja të përdorimit, duke përfshirë një grup mjetesh AI të quajtura agjentë që mund të rezervojnë fluturime ose të dërgojnë email në emër të një përdoruesi. “Do të kemi modele gjithnjë e më të mira”, shkroi Altman në Reddit. “Por unë mendoj se gjëja që do të duket si zbulimi i ardhshëm gjigant do të jenë agjentët.”