Snowflake lëshon një model të vetin gjenerues të AI

Modelet gjeneruese të inteligjencës artificiale të gjithanshme, shumë të përgjithësueshme ishin emri i lojës dikur, dhe ndoshta janë ende. Por gjithnjë e më shumë, ndërsa shitësit e reve të mëdhenj dhe të vegjël i bashkohen përplasjes gjeneruese të AI, ne po shohim një prodhim të ri modelesh të fokusuara te klientët potencialë me xhepa më të thellë: sipërmarrja.

Rasti në fjalë: Snowflake , kompania e kompjuterave cloud, zbuloi sot Arctic LLM, një model gjenerues të AI që përshkruhet si “i shkallës së ndërmarrjes”. I disponueshëm nën një licencë Apache 2.0, Arctic LLM është optimizuar për “ngarkesat e punës së ndërmarrjes”, duke përfshirë gjenerimin e kodit të bazës së të dhënave, thotë Snowflake, dhe është falas për kërkime dhe përdorim komercial.

“Unë mendoj se ky do të jetë themeli që do të na lejojë ne – Snowflake – dhe klientët tanë të ndërtojnë produkte të nivelit të ndërmarrjeve dhe në fakt të fillojnë të kuptojnë premtimin dhe vlerën e AI,” tha CEO Sridhar Ramaswamy në një konferencë për shtyp. ” Ju duhet ta mendoni këtë si hapin tonë të parë, por të madh, në botën e AI gjeneruese, me shumë të tjera që do të vijnë.”

Kohët e fundit kolegu im Devin Coldewey shkroi se si nuk ka fund në horizont sulmi i modeleve gjeneruese të AI. Unë ju rekomandoj të lexoni artikullin e tij , por thelbi është: Modelet janë një mënyrë e thjeshtë për shitësit që të nxisin eksitimin për K&Zh-në e tyre dhe ato shërbejnë gjithashtu si një kanal për ekosistemet e tyre të produkteve (p.sh. pritja e modeleve, rregullimi i mirë etj.).

Arctic LLM nuk është ndryshe. Modeli kryesor i Snowflake në një familje modelesh gjeneruese të AI të quajtur Arctic , Arctic LLM – të cilit iu deshën rreth tre muaj, 1,000 GPU dhe 2 milionë dollarë për t’u trajnuar – mbërrin në fund të DBRX të Databricks , një model gjenerues i AI i tregtuar gjithashtu si i optimizuar për ndërmarrjen. hapësirë.

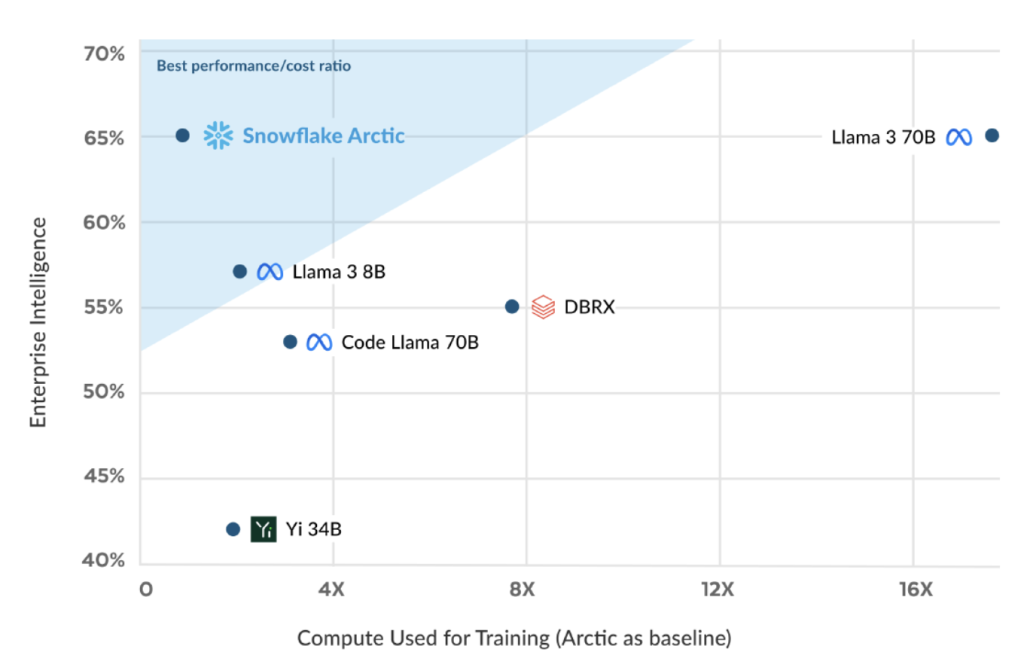

Snowflake bën një krahasim të drejtpërdrejtë midis Arctic LLM dhe DBRX në materialet e tij të shtypit, duke thënë se Arctic LLM tejkalon DBRX në dy detyrat e kodimit (Snowflake nuk specifikoi se cilat gjuhë programimi) dhe gjenerimi SQL . Kompania tha se Arctic LLM është gjithashtu më i mirë në ato detyra sesa Llama 2 70B e Metës (por jo Llama 3 70B më e fundit ) dhe Mistral-i Mixtral-8x7B.

Snowflake gjithashtu pretendon se Arctic LLM arrin “performancë udhëheqëse” në një standard popullor të të kuptuarit të gjuhës së përgjithshme, MMLU. Megjithatë, do të vërej se ndërsa MMLU pretendon të vlerësojë aftësinë e modeleve gjeneruese për të arsyetuar përmes problemeve logjike, ai përfshin teste që mund të zgjidhen përmes memorizimit përmendësh , kështu që merrni atë pikë me pak kripë.

“Arctic LLM adreson nevoja specifike brenda sektorit të ndërmarrjeve,” tha Baris Gultekin, kreu i AI në Snowflake, për TechCrunch në një intervistë, “duke u larguar nga aplikacionet e përgjithshme të AI si kompozimi i poezisë për t’u fokusuar në sfidat e orientuara nga sipërmarrja, si zhvillimi i SQL bashkë. pilotë dhe chatbot me cilësi të lartë.”

Arctic LLM, si DBRX dhe modeli gjenerues me performancë më të mirë të Google të momentit, Gemini 1.5 Pro, është një përzierje e arkitekturës së ekspertëve (MM). Arkitekturat e MM në thelb zbërthejnë detyrat e përpunimit të të dhënave në nën-detyra dhe më pas i delegojnë ato te modele “eksperte” më të vogla dhe të specializuara. Pra, ndërsa Arctic LLM përmban 480 miliardë parametra, ai aktivizon vetëm 17 miliardë në të njëjtën kohë – mjaftueshëm për të drejtuar 128 modelet e veçanta të ekspertëve. (Parametrat në thelb përcaktojnë aftësinë e një modeli AI për një problem, si analizimi dhe gjenerimi i tekstit.)

Snowflake pretendon se ky dizajn efikas i mundësoi asaj të trajnojë Arctic LLM në grupe të dhënash publike të hapura në ueb (përfshirë RefinedWeb, C4, RedPajama dhe StarCoder) me “afërsisht një të tetën e kostos së modeleve të ngjashme”.

Snowflake po ofron burime si shabllone kodimi dhe një listë burimesh trajnimi së bashku me Arctic LLM për të udhëhequr përdoruesit përmes procesit të vënies në punë dhe funksionimit të modelit dhe rregullimit të tij për raste të veçanta përdorimi. Por, duke pranuar se ato ka të ngjarë të jenë ndërmarrje të kushtueshme dhe komplekse për shumicën e zhvilluesve (rregullimi ose ekzekutimi i Arctic LLM kërkon rreth tetë GPU), Snowflake gjithashtu premton të bëjë Arctic LLM të disponueshëm në një sërë hostesh, duke përfshirë Hugging Face, Microsoft Azure, Së bashku shërbimi i mbajtjes së modeleve të AI dhe platforma e AI gjeneruese e ndërmarrjeve Lamini.

Megjithatë, këtu është fshirja: Arctic LLM do të jetë në dispozicion së pari në Cortex, platforma e Snowflake për ndërtimin e aplikacioneve dhe shërbimeve të fuqizuara nga AI dhe mësimi i makinerive. Kompania çuditërisht po e prezanton atë si mënyrën e preferuar për të drejtuar Arctic LLM me “siguri”, “qeverisje” dhe shkallëzueshmëri.

“ Ëndrra jonë këtu është, brenda një viti, të kemi një API që klientët tanë mund ta përdorin në mënyrë që përdoruesit e biznesit të mund të flasin drejtpërdrejt me të dhënat,” tha Ramaswamy. “Do të ishte e lehtë për ne të thoshim, ‘Oh, thjesht do të presim për një model me burim të hapur dhe do ta përdorim atë. Në vend të kësaj, ne po bëjmë një investim themelor sepse mendojmë se [do të zhbllokojë më shumë vlerë për klientët tanë.”

Kështu që unë jam duke pyetur veten: Për kë është vërtet Arctic LLM përveç klientëve të Snowflake?

Në një peizazh plot “ të hapura ” që mund të rregullohen për pothuajse çdo qëllim, Arctic LLM nuk dallohet në asnjë mënyrë të dukshme. Arkitektura e tij mund të sjellë përfitime në efikasitet mbi disa nga opsionet e tjera atje. Por nuk jam i bindur se ato do të jenë mjaft dramatike për t’i larguar ndërmarrjet nga modelet e tjera gjeneruese të panumërta të njohura dhe të mbështetura, miqësore për biznesin (p.sh. GPT-4 ).

Ekziston gjithashtu një pikë në disfavorin e Arctic LLM për t’u marrë parasysh: konteksti i tij relativisht i vogël.

Në AI gjeneruese, dritarja e kontekstit i referohet të dhënave hyrëse (p.sh. teksti) që një model merr parasysh përpara se të gjenerojë output (p.sh. më shumë tekst). Modelet me dritare të vogla të kontekstit janë të prirur të harrojnë përmbajtjen e bisedave edhe më të fundit, ndërsa modelet me kontekste më të mëdha zakonisht e shmangin këtë grackë.

Konteksti i Arctic LLM është midis ~ 8,000 dhe ~ 24,000 fjalë, në varësi të metodës së akordimit – shumë më poshtë se ai i modeleve si Claude 3 Opus i Anthropic dhe Gemini 1.5 Pro i Google.

Snowflake nuk e përmend atë në marketing, por Arctic LLM pothuajse me siguri vuan nga të njëjtat kufizime dhe mangësi si modelet e tjera gjeneruese të AI – domethënë, halucinacionet (dmth. duke iu përgjigjur me besim kërkesave gabimisht). Kjo për shkak se Arctic LLM, së bashku me çdo model tjetër gjenerues të AI në ekzistencë, është një makinë probabiliteti statistikor – një makinë që, përsëri, ka një dritare të vogël konteksti. Ai supozon bazuar në një numër të madh shembujsh se cilat të dhëna kanë më “kuptim” për të vendosur (p.sh. fjala “shko” përpara “tregut” në fjalinë “Unë shkoj në treg”). Në mënyrë të pashmangshme do të hamendësohet gabim – dhe ky është një “halucinacion”.

Siç shkruan Devin në artikullin e tij, deri në përparimin tjetër të madh teknik, përmirësimet në rritje janë gjithçka që duhet të presim në domenin gjenerues të AI. Megjithatë, kjo nuk do t’i ndalojë shitësit si Snowflake që t’i mbrojnë ato si arritje të mëdha, dhe t’i tregtojnë ato për gjithçka që vlejnë.