Studiuesit e Meta distilojnë të menduarit e Sistemit 2 në LLM, duke përmirësuar performancën në arsyetimin kompleks

Modelet e mëdha të gjuhës (LLM) janë shumë të mira në përgjigjen e pyetjeve të thjeshta, por kërkojnë teknika të veçanta nxitëse për të trajtuar detyra komplekse që kanë nevojë për arsyetim dhe planifikim. Shpesh të referuara si teknika “Sistemi 2”, këto skema nxitëse rrisin aftësitë e arsyetimit të LLM-ve duke i detyruar ata të gjenerojnë hapa të ndërmjetëm drejt zgjidhjes së një problemi.

Ndërsa efektive, teknikat e Sistemit 2 i bëjnë aplikacionet LLM të ngadalta dhe të shtrenjta nga ana llogaritëse. Në një punim të ri, studiuesit në Meta FAIR prezantojnë ” Distilimin e Sistemit 2 “, një teknikë që u mëson LLM-ve detyra komplekse pa kërkuar hapa të ndërmjetëm.

Në shkencën njohëse, Sistemi 1 dhe Sistemi 2 i referohen dy mënyrave të ndryshme të të menduarit. Mendimi i Sistemit 1 është i shpejtë, intuitiv dhe automatik. Është ajo që ne përdorim kur njohim modele, bëjmë gjykime të shpejta ose kuptojmë simbole të njohura. Për shembull, ne përdorim të menduarit e Sistemit 1 për të identifikuar shenjat e trafikut, për të njohur fytyrat dhe për të lidhur simbolet bazë me kuptimet e tyre.

Mendimi i Sistemit 2, nga ana tjetër, është i ngadalshëm, i qëllimshëm dhe analitik. Kërkon përpjekje të vetëdijshme dhe përdoret për zgjidhjen komplekse të problemeve, të tilla si manipulimi i simboleve abstrakte, zgjidhja e ekuacioneve matematikore ose planifikimi i një udhëtimi.

LLM-të zakonisht konsiderohen analoge me të menduarit e Sistemit 1. Ata mund të gjenerojnë tekst shumë shpejt, por ata luftojnë me detyra që kërkojnë arsyetim dhe planifikim të qëllimshëm.

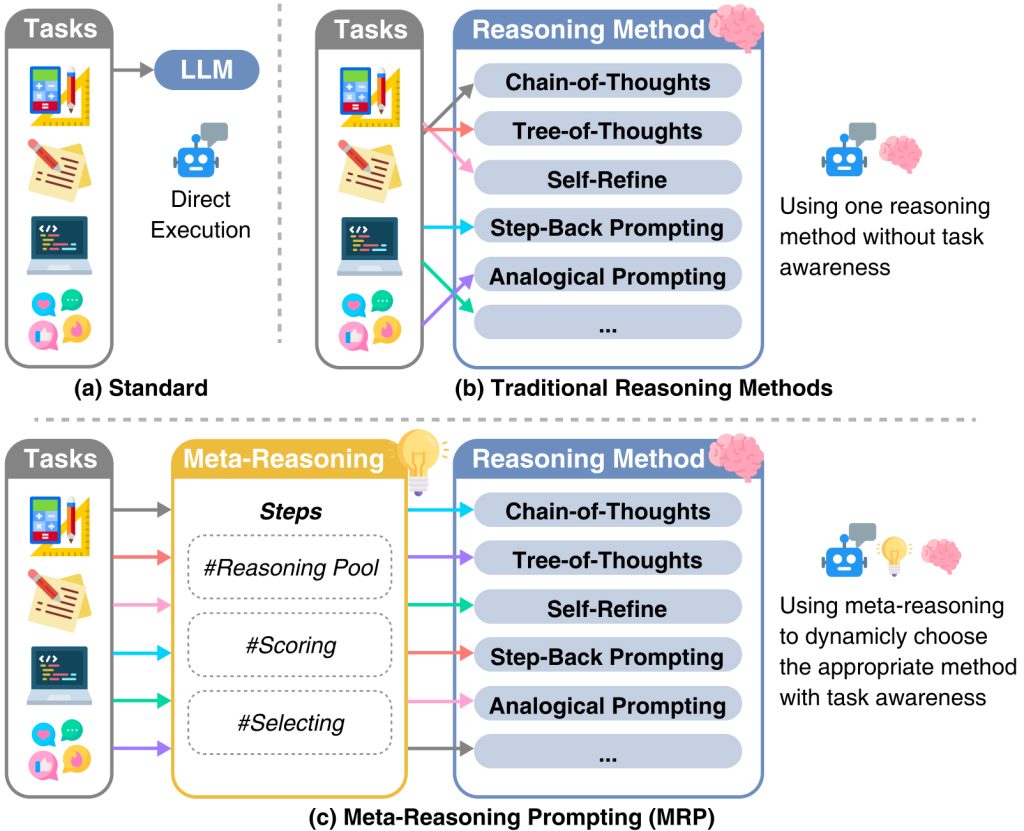

Vitet e fundit, studiuesit e AI kanë treguar se LLM-të mund të bëhen për të imituar të menduarit e Sistemit 2 duke i nxitur ata të gjenerojnë hapa të ndërmjetëm arsyetimi përpara se të japin përgjigjen e tyre përfundimtare. Për shembull, ” Zinxhiri i mendimit ” është një teknikë nxitëse që udhëzon LLM të shpjegojë procesin e saj të arsyetimit hap pas hapi, gjë që shpesh çon në rezultate më të sakta për detyrat e arsyetimit logjik. Disa teknika nxitëse të Sistemit 2 janë përshtatur për detyra të ndryshme.

“Shumë nga këto metoda tregohen se prodhojnë rezultate më të sakta për shkak të këtij arsyetimi të qartë, por zakonisht e bëjnë këtë me kosto shumë më të lartë konkluzion dhe vonesë për një përgjigje,” shkruajnë studiuesit e Meta AI. “Për shkak të kësaj të fundit, shumë nga këto qasje nuk përdoren në sistemet e prodhimit, të cilat kryesisht përdorin gjeneratat e Sistemit 1.”

Një vëzhgim interesant rreth të menduarit të Sistemit 2 tek njerëzit është se kur ne kryejmë në mënyrë të përsëritur një detyrë që kërkon përpjekje të qëllimshme, ajo gradualisht rrënjoset në Sistemin tonë 1. Për shembull, kur mësoni të drejtoni makinën, ju përdorni shumë përpjekje të vetëdijshme për të kontrolluar makinë, ndiqni rregullat e trafikut dhe lundroni. Por ndërsa fitoni më shumë përvojë, ngasja bëhet natyrë e dytë. Nuk keni më nevojë të mendoni për çdo hap dhe mund t’i kryeni ato në mënyrë intuitive dhe automatike.

Ky fenomen frymëzoi studiuesit e Meta AI për të zhvilluar “distilimin e Sistemit 2” për LLM.

Distilimi është një teknikë e zakonshme në mësimin e makinerive (ML), ku një model më i madh, i referuar si “mësuesi”, përdoret për të trajnuar një model më të vogël, ose “student”. Për shembull, zhvilluesit shpesh përdorin modele kufitare si GPT-4 dhe Claude për të gjeneruar shembuj trajnimi për modele më të vogla si Llama-2 7B.

Megjithatë, distilimi i Sistemit 2 nuk përdor një model të veçantë mësuesi. Në vend të kësaj, studiuesit gjetën një mënyrë për të distiluar njohuritë e marra nga aftësitë e arsyetimit të sistemit 2 të modelit në gjeneratën e tij me ritme të shpejta dhe efikase në llogaritjen e Sistemit 1.

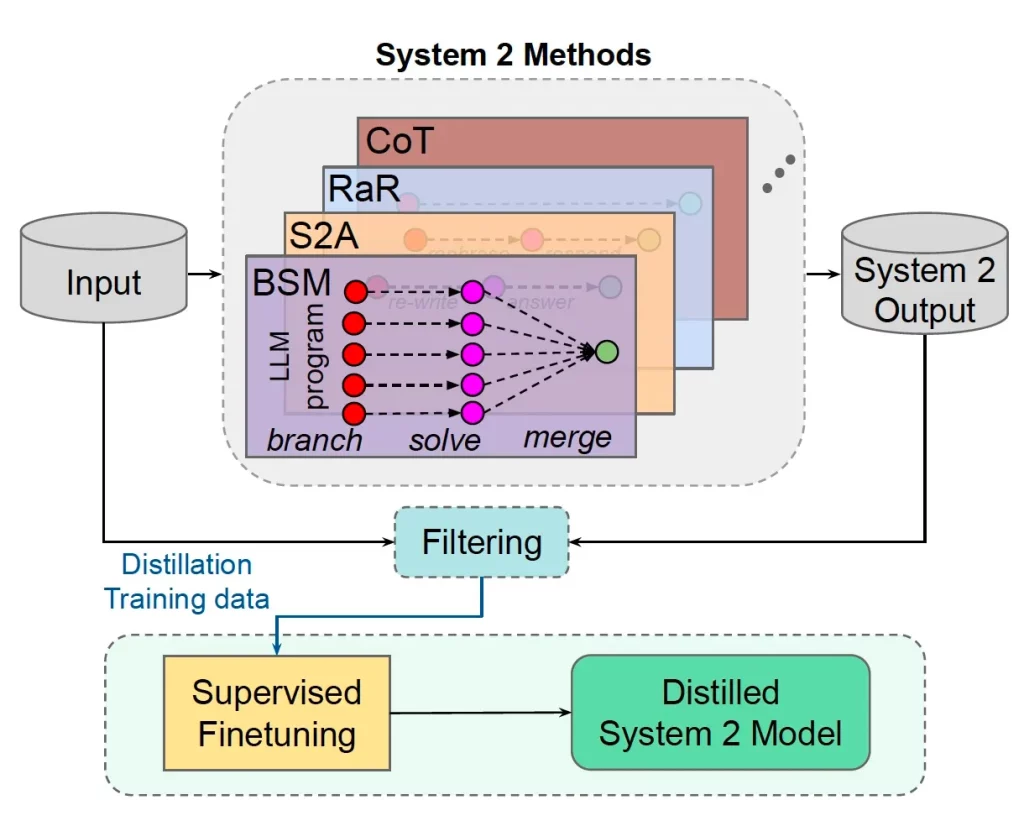

Procesi fillon duke nxitur LLM të zgjidhë një problem duke përdorur teknikat e nxitjes së Sistemit 2. Përgjigjet më pas verifikohen për korrektësi përmes një mekanizmi të pambikëqyrur. Për shembull, ata përdorin “konsistencën e vetvetes”, ku modelit i jepet e njëjta kërkesë shumë herë. Përgjigjet e tij më pas krahasohen dhe ajo që shfaqet më shpesh konsiderohet përgjigja e saktë dhe zgjidhet për grupin e të dhënave të distilimit. Nëse përgjigjet janë shumë jokonsistente, atëherë shembulli dhe përgjigjet e tij hidhen poshtë.

Më pas, ata hedhin poshtë hapat e ndërmjetëm të krijuar nga arsyetimi i Sistemit 2 dhe mbajnë vetëm përgjigjet përfundimtare. Më në fund, ata e rregulluan modelin në pyetjen fillestare dhe përgjigjen. Kjo i lejon modelit të kapërcejë hapat e arsyetimit dhe të hidhet drejtpërsëdrejti te përgjigjja.

Studiuesit vlerësuan metodën e tyre në një sërë detyrash arsyetimi dhe katër teknika të ndryshme nxitëse të Sistemit 2. Për modelin bazë, ata përdorën Llama-2-70B, e cila është mjaft e madhe për të pasur kapacitetin për të përvetësuar njohuritë e reja.

Qasjet e Sistemit 2 që ata përdorën në eksperimentet e tyre përfshijnë Zinxhiri i Mendimit, Sistemi 2 Vëmendje , Riformulimi dhe Përgjigjja dhe Dega-Zgjidhja-Shkrirja. Disa nga këto teknika kërkojnë që modeli të nxitet disa herë, gjë që i bën ato të ngadalta dhe të shtrenjta. Për shembull, Refrase and Respond fillimisht e nxit modelin të riformulojë pyetjen origjinale me shtjellim, dhe më pas riformulon modelin me pyetjen e riformuluar. Branch-Solve-Merge është edhe më i ndërlikuar dhe kërkon shumë ndryshime me modelin.

Rezultatet tregojnë se distilimi i Sistemit 2 mund të përmirësojë ndjeshëm performancën e LLM-ve në detyrat komplekse të arsyetimit, shpesh duke përputhur ose tejkaluar saktësinë e metodave origjinale të Sistemit 2. Për më tepër, modelet e distiluara mund të gjenerojnë përgjigje shumë më shpejt dhe me më pak llogaritje, sepse nuk duhet të kalojnë nëpër hapat e arsyetimit të ndërmjetëm.

Për shembull, ata zbuluan se distilimi ishte i suksesshëm për detyrat që përdorin Sistemin 2 Vëmendje për t’u marrë me opinione të njëanshme ose informacione të parëndësishme. Ai tregoi gjithashtu rezultate mbresëlënëse në disa detyra arsyetimi, ku Refraze and Respond përdoret për të sqaruar dhe përmirësuar përgjigjet, dhe për vlerësimin dhe përpunimin e hollësishëm të detyrave përmes Branch-Solve-Merge.

“Ne kemi treguar se në shumë raste është e mundur të distilohet ky arsyetim i Sistemit 2 në rezultatet e LLM pa gjenerata të ndërmjetme duke ruajtur, ose ndonjëherë edhe duke përmirësuar, performancën,” shkruajnë studiuesit.

Megjithatë, studiuesit zbuluan gjithashtu se, si njerëzit, LLM-të nuk mund të distilojnë të gjitha llojet e aftësive të arsyetimit në mekanizmin e tyre të konkluzionit me ritëm të shpejtë. Për shembull, ata nuk ishin në gjendje të distilonin me sukses detyrat komplekse të arsyetimit të matematikës që kërkonin nxitje të Zinxhirit të Mendimit . Kjo sugjeron që disa detyra mund të kërkojnë gjithmonë arsyetim të qëllimshëm.

Ka shumë më tepër për të mësuar rreth distilimit të Sistemit 2, si p.sh. sa mirë funksionon në modele më të vogla dhe sesi distilimi ndikon në performancën më të gjerë të modelit në detyrat që nuk janë përfshirë në grupin e të dhënave të trajnimit të distilimit. Vlen gjithashtu të theksohet se standardet LLM shpesh janë të prirur ndaj kontaminimit, ku modeli tashmë ka një lloj njohurie për shembujt e testit, duke rezultuar në rezultate të fryra në grupet e testeve.

Sidoqoftë, distilimi me siguri do të jetë një mjet i fuqishëm optimizimi për tubacionet e pjekura LLM që kryejnë detyra specifike në çdo hap.

“Duke parë përpara, sistemet që mund të distilojnë detyra të dobishme në këtë mënyrë lirojnë më shumë kohë për të shpenzuar në arsyetimin rreth detyrave që ata ende nuk mund t’i bëjnë mirë, ashtu siç bëjnë njerëzit,” shkruajnë studiuesit.