Amazon gati për të përdorur çipat e veta të AI, zvogëlon varësinë e saj nga Nvidia

Amazon është gati të lançojë çipat e saj më të rinj të inteligjencës artificiale pasi grupi Big Tech kërkon kthime nga investimet e tij gjysmëpërçuese shumë miliarda dollarësh dhe për të reduktuar varësinë e tij tek lideri i tregut Nvidia.

Ekzekutivët në divizionin e kompjuterëve cloud të Amazon po shpenzojnë shumë për çipat e personalizuar me shpresën për të rritur efikasitetin brenda dhjetëra qendrave të tij të të dhënave, duke ulur përfundimisht kostot e veta si dhe ato të klientëve të Shërbimeve Ueb të Amazon.

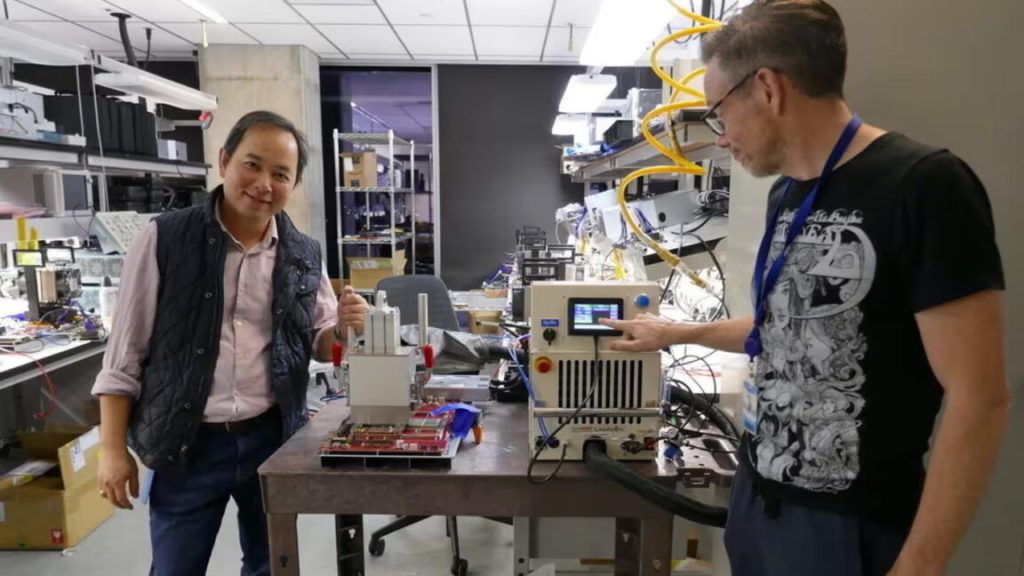

Përpjekja drejtohet nga Annapurna Labs, një start-up me bazë në Austin, të cilin Amazon e bleu në fillim të vitit 2015 për 350 milionë dollarë. Puna e fundit e Annapurna pritet të shfaqet muajin e ardhshëm kur Amazon njofton disponueshmërinë e gjerë të ‘Trainium 2’, pjesë e një linje çipash AI që synojnë trajnimin e modeleve më të mëdha.

Trainium 2 tashmë po testohet nga Anthropic – konkurrenti OpenAI që ka siguruar 4 miliardë dollarë mbështetje nga Amazon – si dhe Databricks, Deutsche Telekom dhe Ricoh dhe Stockmark të Japonisë.

Objektivi i AWS dhe Annapurna është të përballen me Nvidia, një nga kompanitë më të vlefshme në botë falë dominimit të saj në tregun e procesorëve AI.

“Ne duam të jemi absolutisht vendi më i mirë për të drejtuar Nvidia,” tha Dave Brown, nënkryetar i shërbimeve kompjuterike dhe rrjeteve në AWS. “Por në të njëjtën kohë ne mendojmë se është e shëndetshme të kemi një alternativë.” Amazon tha se ‘Inferentia’, një tjetër nga linjat e saj të çipave të specializuar të AI, tashmë është 40 për qind më e lirë për të gjeneruar përgjigje nga modelet e AI.

“Çmimi [i kompjuterit cloud] priret të jetë shumë më i madh kur bëhet fjalë për mësimin e makinerive dhe AI,” tha Brown. “Kur kurseni 40 për qind të 1000 dollarëve, nuk do të ndikojë në zgjedhjen tuaj. Por kur kurseni 40 për qind në dhjetëra miliona dollarë, kjo ndodh.”

Amazon tani pret rreth 75 miliardë dollarë shpenzime kapitale në vitin 2024, me shumicën në infrastrukturën teknologjike. Në thirrjen e fundit të të ardhurave të kompanisë, shefi ekzekutiv Andy Jassy tha se ai pret që kompania të shpenzojë edhe më shumë në 2025.

Kjo përfaqëson një rritje në vitin 2023, kur shpenzoi 48.4 miliardë dollarë për të gjithë vitin. Ofruesit më të mëdhenj të reve kompjuterike, duke përfshirë Microsoft dhe Google, janë të gjithë të përfshirë në një zbavitje të shpenzimeve të AI që tregon pak shenja pakësimi.

Amazon, Microsoft dhe Meta janë të gjithë klientë të mëdhenj të Nvidia, por po dizajnojnë gjithashtu çipat e tyre të qendrës së të dhënave për të hedhur themelet për atë që ata shpresojnë se do të jetë një valë e rritjes së AI.

“Secili nga ofruesit e mëdhenj të reve kompjuterike po lëviz me ethe drejt një grupi më të vertikalizuar dhe, nëse është e mundur, më homogjenizuar dhe integruar [teknologjia e çipave]”, tha Daniel Newman në The Futurum Group.

“Të gjithë nga OpenAI te Apple po kërkojnë të ndërtojnë çipat e tyre,” vuri në dukje Newman, pasi ata kërkojnë “kosto më të ulët të prodhimit, marzhe më të larta, disponueshmëri më të madhe dhe më shumë kontroll”.

“Nuk ka të bëjë vetëm me çipin, ka të bëjë me sistemin e plotë,” tha Rami Sinno, drejtor i inxhinierisë së Annapurna dhe një veteran i SoftBank’s Arm dhe Intel.

Për infrastrukturën e inteligjencës artificiale të Amazon-it, kjo do të thotë të ndërtosh gjithçka nga themeli, nga vafera e silikonit deri te raftet e serverëve në të cilat përshtaten, të gjitha të mbështetura nga softueri dhe arkitektura e pronarit të Amazon. “Është vërtet e vështirë të bëjmë atë që bëjmë në shkallë. Jo shumë kompani munden”, tha Sinno.

Pasi filloi ndërtimin e një çipi sigurie për AWS të quajtur Nitro, Annapurna që atëherë ka zhvilluar disa gjenerata të Graviton, njësitë e saj qendrore të përpunimit të bazuara në krahë që ofrojnë një alternativë me fuqi të ulët ndaj kuajve të punës tradicionale të serverëve të ofruar nga Intel ose AMD.

“Avantazhi i madh i AWS është se çipat e tyre mund të përdorin më pak energji dhe qendrat e tyre të të dhënave ndoshta mund të jenë pak më efikase,” duke ulur kostot, tha G Dan Hutcheson, analist në TechInsights. Nëse njësitë e përpunimit grafik të Nvidia-s janë mjete të fuqishme për qëllime të përgjithshme – në terma automobilistikë, si një karroce apo automobil – Amazon mund të optimizojë çipat e tij për detyra dhe shërbime specifike, si një kompakt apo hatchback, tha ai.

Sidoqoftë, deri më tani, AWS dhe Annapurna mezi e kanë dëmtuar dominimin e Nvidia në infrastrukturën e AI.

Nvidia regjistroi 26.3 miliardë dollarë të ardhura për shitjet e çipave të qendrës së të dhënave AI në tremujorin e dytë fiskal të 2024. Kjo shifër është e njëjtë me atë që Amazon njoftoi për të gjithë divizionin e saj AWS në tremujorin e dytë fiskal—vetëm një pjesë relativisht e vogël e së cilës mund t’i atribuohet për klientët që kryejnë ngarkesa pune të AI në infrastrukturën e Annapurna-s, sipas Hutcheson.

Sa i përket performancës së papërpunuar të çipave AWS në krahasim me ato të Nvidia-s, Amazon shmang krahasimet e drejtpërdrejta dhe nuk i paraqet çipat e tij për standarde të pavarura të performancës.

“Kapelet janë të mira për atë fillestar: ‘hej, a duhet ta konsideroj edhe këtë çip’,” tha Patrick Moorhead, një konsulent çipash në Moor Insights & Strategy, por testi i vërtetë është kur ato vendosen “në rafte të shumta të vendosura së bashku si një flota.”

Moorhead tha se ai është i bindur se pretendimet e Amazon për një rritje 4 herë të performancës midis Trainium 1 dhe Trainium 2 janë të sakta, pasi e kanë shqyrtuar kompaninë për vite me radhë. Por shifrat e performancës mund të kenë më pak rëndësi sesa thjesht t’u ofroni klientëve më shumë zgjedhje.

“Njerëzit vlerësojnë të gjithë inovacionin që solli Nvidia, por askush nuk është i kënaqur që Nvidia ka 90 për qind të tregut,” shtoi ai. “Kjo nuk mund të zgjasë shumë.”