Prezantimi i Claude Haiku 4.5

Anthropic publikoi sot Claude Haiku 4.5, anëtarin më të lirë të familjes Claude 4.5 që filloi me Sonnet 4.5 disa javë më parë.

Çmimi i tij është 1 dollar/milion tokena hyrëse dhe 5 dollar/milion tokena dalëse, pak më i shtrenjtë se Haiku 3.5 (0.80 dollarë/4 dollarë) dhe shumë më i shtrenjtë se Haiku origjinal Claude 3 (0.25 dollarë/1.25 dollarë), të cilët mbeten të disponueshëm me këto çmime.

Është një e treta e çmimit të Sonnet 4 dhe Sonnet 4.5 (të dyja $3/$15), gjë që është e rëndësishme sepse testet e Anthropic e vendosin atë në një hapësirë të ngjashme me modelin më të vjetër Sonnet 4. Siç e thanë ata:

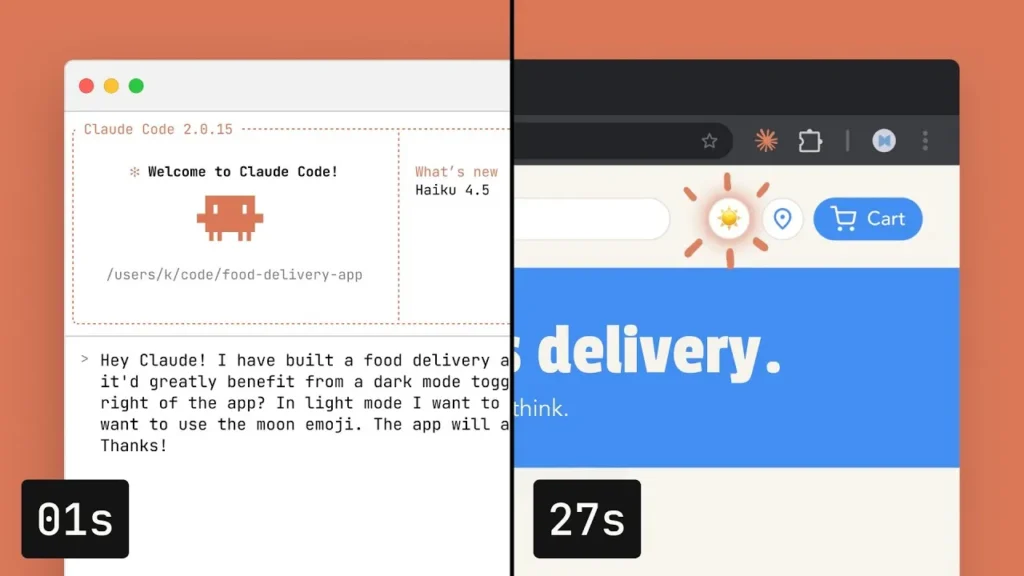

Ajo që kohët e fundit ishte në front, tani është më e lirë dhe më e shpejtë. Pesë muaj më parë, Claude Sonnet 4 ishte një model i teknologjisë së fundit. Sot, Claude Haiku 4.5 ju ofron nivele të ngjashme të performancës së kodimit, por me një të tretën e kostos dhe më shumë se dyfishin e shpejtësisë.

Kam shpresuar ta shoh Anthropic të lançojë një model të shpejtë, të lirë dhe konkurrues në çmim me modelet më të lira nga OpenAI dhe Gemini, aktualisht 0.05 dollarë/0.40 dollarë (GPT-5-Nano) dhe 0.075 dollarë/0.30 dollarë (Gemini 2.0 Flash Lite). Haiku 4.5 sigurisht që nuk është ky, duket sikur po vazhdojnë të përqendrohen drejtpërdrejt në pjesën e tregut “të shkëlqyer në kodim”.

Haiku i ri është modeli i parë Haiku që mbështet arsyetimin. Ai ka një dritare konteksti prej 200,000 tokenësh, një dalje maksimale prej 64,000 (nga vetëm 8,192 për Haiku 3.5) dhe një “kufir të besueshëm të njohurive” në shkurt 2025, një muaj më vonë se data e janarit 2025 për Sonnet 4 dhe 4.5 dhe Opus 4 dhe 4.1.

Diçka që më tërhoqi vëmendjen në kartën e sistemit shoqërues ishte ky shënim në lidhje me gjatësinë e kontekstit:

Për Claude Haiku 4.5, ne e trajnuam modelin që të jetë në mënyrë eksplicite i vetëdijshëm për kontekstin, me informacion të saktë se sa është përdorur dritarja e kontekstit. Kjo ka dy efekte: modeli mëson se kur dhe si ta përfundojë përgjigjen e tij kur limiti po afrohet, dhe modeli mëson të vazhdojë të arsyetojë më me këmbëngulje kur limiti është më larg. Ne zbuluam se kjo ndërhyrje – së bashku me të tjerat – është efektive në kufizimin e “dembelizmit” agjentik (fenomeni ku modelet ndalojnë së punuari në një problem para kohe, japin përgjigje të paplota ose shkurtojnë detyrat).

E kam shtuar çmimin e ri në llm-prices.com, kam publikuar llm-anthropic 0.20 me modelin e ri dhe kam përditësuar demon time Haiku-from-your-webcam ( burimi ) për të përdorur edhe Haiku 4.5.