Z.ai publikon GLM-4.7, duke pretenduar barazi me GPT-5.1 me “ruajtje të të menduarit” për agjentët

GLM-4.7 është një model me pesha të hapura me paritet referues me GPT-5.1 dhe Claude Sonnet 4.5.

Laboratori kinez i inteligjencës artificiale Zhipu AI (Z.ai) ka publikuar GLM-4.7, një model të ri që pretendon të jetë i barabartë me modelet kufitare pronësore si GPT-5.1 në detyrat e kodimit dhe arsyetimit.

E projektuar posaçërisht për agjentë autonomë, arkitektura prezanton “Mendimin e Ruajtur”, një veçori që ruan zinxhirët e arsyetimit në të gjitha rrjedhat e punës me shumë hapa për të parandaluar humbjen e kontekstit.

I lançuar të hënën, përditësimi përforcon angazhimin e Z.ai për platforma të hapura, edhe pse konkurrentë si Meta po kalojnë drejt platformave të mbyllura.

Teknikisht, arkitektura trajton një mënyrë dështimi në rrjedhat e punës agjentike: prishjen e kontekstit. Në detyrat me horizont të gjatë, modelet shpesh ekzekutojnë hapa individualë në mënyrë korrekte, por humbasin gjurmët e logjikës mbizotëruese ose “pse”-së pas vendimeve të mëparshme ndërsa dritarja e kontekstit mbushet.

Ruajtja standarde e kontekstit në memorje ruan tokenët e papërpunuar të hyrjes, por zakonisht i hedh poshtë gjendjet e ndërmjetme të arsyetimit të gjeneruara gjatë inferencës. GLM-4.7 e ndryshon këtë duke zbatuar një mekanizëm të përshkruar në dokumentacionin teknik që i ruan këto “blloqe të të menduarit” gjatë gjithë seancës.

Ka përmirësime të rëndësishme në arkitekturën njohëse të modelit, konkretisht duke u bazuar në aftësitë e “Mendimit të Ndërthurur” të para në GLM-4.5. Shtesa më e dukshme është “Mendimi i Ruajtur”, një mekanizëm i projektuar posaçërisht për agjentët e kodimit që veprojnë gjatë seancave të gjata.

Në modelet tradicionale, hapat e arsyetimit shpesh hidhen poshtë pasi gjenerohet një përgjigje, duke e detyruar sistemin të ripërcaktojë logjikën e tij për kthesat pasuese. GLM-4.7 i ruan automatikisht këto “blloqe të të menduarit” gjatë gjithë bisedës, duke i lejuar asaj të ripërdorë arsyetimin e vendosur në vend që ta llogarisë atë nga e para.

Për ta plotësuar këtë është “Të menduarit në nivel turni”, i cili prezanton një shtresë kontrolli të detajuar për zhvilluesit. Kjo veçori lejon që modaliteti i arsyetimit të aktivizohet ose çaktivizohet për kërkesa specifike brenda të njëjtës seancë.

Ky fleksibilitet mundëson një fluks pune hibrid me kosto efektive: inxhinierët mund të çaktivizojnë të menduarit e thellë për detyra të lehta dhe të ndjeshme ndaj vonesës për të kursyer kostot e nxjerrjes së përfundimeve, ndërkohë që e mundësojnë atë në mënyrë selektive për udhëzime komplekse dhe me rrezik të lartë, ku saktësia dhe stabiliteti janë parësore.

Duke e trajtuar arsyetimin si një fije të vazhdueshme në vend të ngjarjeve të izoluara të nxjerrjes së përfundimeve, sistemi zvogëlon mbingarkesën llogaritëse të logjikës së ri-nxjerrjes për çdo thirrje të re mjeti. Kjo aftësi është e ndryshme nga memoria e thjeshtë; ajo i lejon agjentit të mbajë një “tren mendimi” që vazhdon përmes ndërprerjeve dhe ndërveprimeve të API-ve të jashtme.

Zhvilluesit mund ta menaxhojnë këtë ngarkesë llogaritëse përmes një veçorie të quajtur “Të menduarit në nivel kthese”. Sipas Z.ai, ky mekanizëm kontrolli u lejon inxhinierëve të aktivizojnë ose çaktivizojnë aftësitë e arsyetimit për kërkesa specifike brenda një seance të vetme.

Çaktivizimi i funksionit për detyra të lehta, siç janë përditësimet e thjeshta të ndërfaqes së përdoruesit ose rikthimi i të dhënave, zvogëlon vonesën dhe kostot e nxjerrjes së përfundimeve. Anasjelltas, aktivizimi i tij për operacione komplekse, siç janë rifaktrimi i kodit ose planifikimi me shumë hapa, i jep saktësi maksimale llogaritjes.

Për të lehtësuar adaptimin në mjediset e ndërmarrjeve, Z.ai ka siguruar përputhshmëri me kornizat standarde të inferencës. Modeli lançohet me mbështetje native për vLLM dhe SGLang, duke e lejuar atë të kalojë në tubacionet ekzistuese të prodhimit pa ri-inxhinierim.

Ndërsa numrat e papërpunuar tregojnë një pjesë të historisë, Z.ai e ka pozicionuar GLM-4.7 drejtpërdrejt kundrejt nivelit “të lartë” të modeleve pronësore, duke synuar konkretisht GPT-5.1 dhe Claude Sonnet 4.5.

Duke operuar me një dritare konteksti prej 131,072 tokenësh, sistemi mund të përthithë baza të mëdha kodesh ose dokumentacion në një kalim të vetëm. Cilësimet e parazgjedhura të inferencës rekomandojnë një temperaturë prej 1.0 dhe p-në maksimale prej 0.95, duke treguar besim në stabilitetin e modelit pa kufizime të marrjes së mostrave.

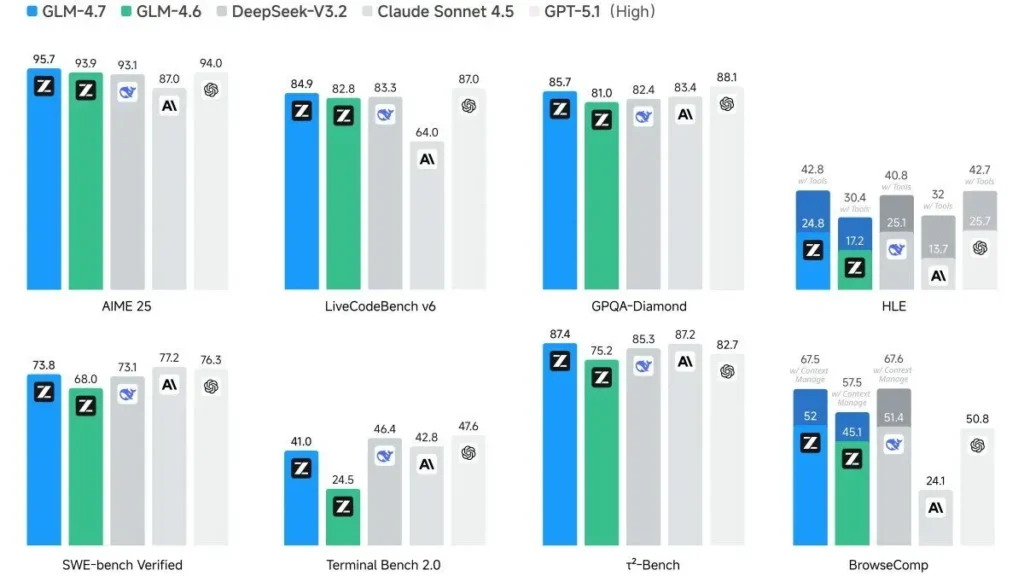

Kompania publikoi të dhëna të performancës për të mbështetur këto pretendime, megjithëse analistët e pavarur ende nuk i kanë verifikuar publikisht këto shifra.

Në testin AIME 25, i cili vlerëson arsyetimin e avancuar matematik, modeli arriti një rezultat prej 95.7. Kjo shifër tejkalon rezultatin 94.0 të regjistruar nga GPT-5.1 High.

Performanca në testin e Humanity’s Last Exam (HLE) ilustron më tej thellësinë e arsyetimit të modelit. Kur ishte i pajisur me mjete, GLM-4.7 shënoi një rezultat prej 42.8, duke tejkaluar rezultatin prej 42.7 të GPT-5.1 High. Një rritje prej 12.4 pikësh përqindjeje krahasuar me GLM-4.6 të gjeneratës së mëparshme shënon një kërcim brez pas brezi.

Në detyrat e kodimit, rezultatet paraqesin një profil konkurrues. Modeli mori një rezultat prej 84.9 në LiveCodeBench v6, duke mbetur pas rezultatit prej 87.0 të GPT-5.1 High, por duke ruajtur një pozicion midis alternativave me peshë të hapur. Në mënyrë të ngjashme, në SWE-bench Verified, ai arriti një rezultat prej 73.8.

Pavarësisht këtyre përfitimeve sasiore, ekipi i zhvillimit thekson se metrikat nuk janë treguesi i vetëm i dobisë:

“AGI është një udhëtim i gjatë dhe standardet janë vetëm një mënyrë për të vlerësuar performancën. Ndërsa metrikat ofrojnë pikat e kontrollit të nevojshme, gjëja më e rëndësishme është ende se si ndihet.”

Dinamikat e tregut sugjerojnë një divergjencë në strategjitë e vendosjes së inteligjencës artificiale. Ndërsa Z.ai vazhdon të publikojë peshat në Hugging Face, lojtarë të tjerë të mëdhenj po tërhiqen nga platformat e hapura.

Një filozofi e tillë ndryshon nga orientimi i supozuar i Metës drejt modeleve pronësore. Raportet tregojnë se Meta po e zhvendos fokusin e saj te projektet e mbyllura ‘Mango’ dhe ‘Avokado’ për vitin 2026, duke u larguar nga linja e hapur e Llamës që përcaktonte strategjinë e saj të mëparshme.

Z.ai ka ruajtur një orar të shpeshtë publikimesh gjatë gjithë vitit 2025. Ky lançim vjen pas publikimit të GLM-4.5 në korrik, i cili synonte raportin çmim-performancë të DeepSeek, dhe modelit vizual GLM-4.6V në fillim të këtij muaji.

Përsëritja e shpeshtë përcakton planin e kompanisë për vitin 2025, duke sugjeruar një strategji të fokusuar në kapjen e mendimit të zhvilluesve duke ofruar aftësi në infrastrukturën e aksesueshme. Mundësia për të përdorur këto modele në harduer vendas në Kinë, siç janë çipat H20 të Nvidia-s, mbetet një faktor i domosdoshëm për tregun primar të kompanisë në vend, ku kontrollet e eksportit të SHBA-së kufizojnë aksesin në GPU-të e nivelit më të lartë.

Duke u përqendruar në “kodimin” si rruga kryesore për integrimin e AGI-së, kompania parashikon që mjetet e zhvilluesve do të jenë domeni i parë ku agjentët autonomë arrijnë dobi:

“Inteligjenca e vërtetë nuk ka të bëjë vetëm me kalimin me sukses në një test ose përpunimin më të shpejtë të të dhënave; në fund të fundit, suksesi i IAG-së do të matet nga mënyra se si integrohet pa probleme në jetën tonë, duke ‘koduar’ këtë herë.”