Zhvilluesit kinezë të inteligjencës artificiale po shqyrtojnë marrjen me qira të GPU-së Rubin të Nvidia-s në cloud kostoja, kompleksiteti dhe pengesat rregullatore mund të kufizojnë përdorimin

Zhvilluesit e pajisjeve të inteligjencës artificiale me bazë në Kinë po bëjnë përparim të shpejtë me përshpejtuesit e dizajnit të tyre. Megjithatë, zhvilluesit më të përparuar të inteligjencës artificiale në Kinë po e pranojnë gjithnjë e më shumë se pajisjet vendase nuk kanë gjasa të arrijnë liderët amerikanë në të ardhmen e afërt, gjë që kufizon shumë zhvillimin e modeleve konkurruese. Për këtë qëllim, në një përpjekje për të qëndruar konkurrues me kolegët amerikanë, zhvilluesit kinezë të inteligjencës artificiale po eksplorojnë mënyra për të marrë me qira GPU-të e ardhshme Rubin të Nvidia në cloud, raporton Wall Street Journal.

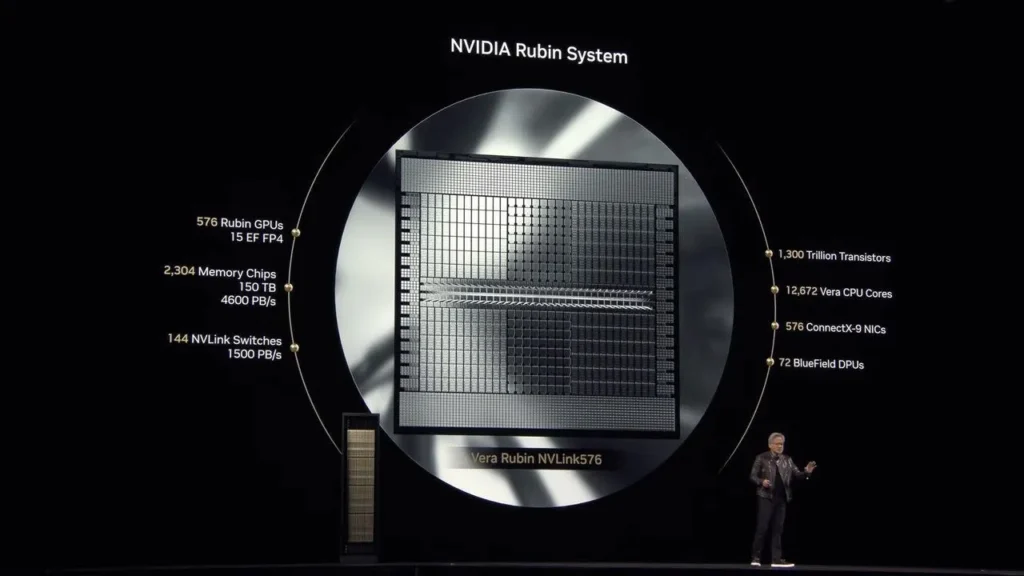

Kur Nvidia prezantoi platformën e saj të qendrës së të dhënave Rubin për inteligjencën artificiale në janar, ajo i emëroi publikisht klientët amerikanë dhe i la jashtë ata kinezë. Kompania e ka ndjekur këtë qasje në tremujorët e fundit, duke reflektuar rregullat e eksportit të SHBA-së, angazhimin e saj për t’iu përmbajtur atyre dhe qëllimin e saj për të mos u sinjalizuar investitorëve për hapjen e tregut kinez. Mesazhi u mor nga kompanitë kineze dhe ato filluan të eksploronin mënyra për të marrë procesorë të teknologjisë së fundit nga Nvidia nga distanca për të shmangur mbetjen prapa rivalëve të tyre amerikanë.

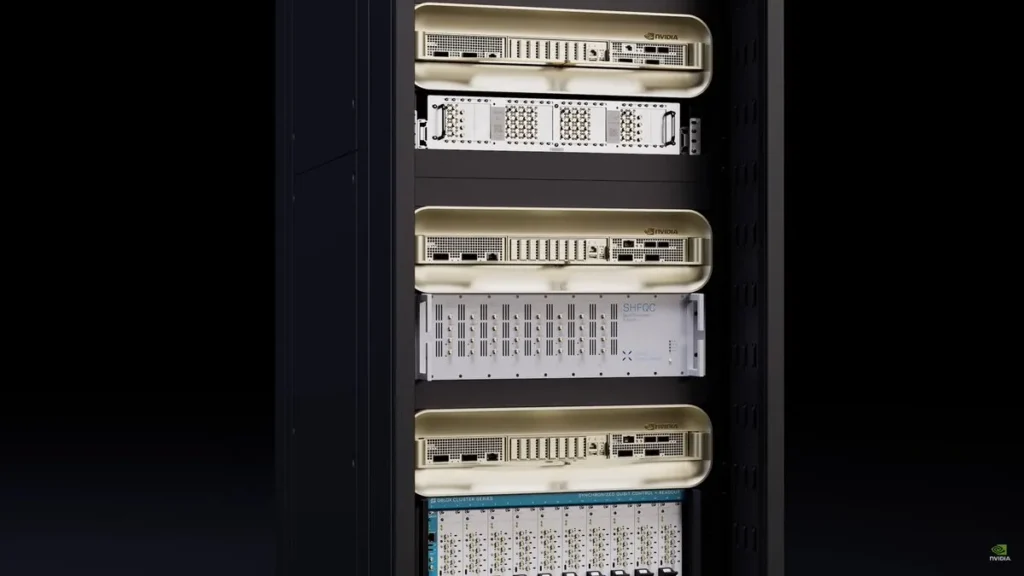

Raporti pohon se kompanitë kineze të inteligjencës artificiale kanë filluar negociatat për akses në NVL144 GR200 dhe sisteme të tjera të bazuara në Nvidia Rubin të vendosura në qendra të dhënash jashtë Kinës, veçanërisht në Azinë Juglindore dhe Lindjen e Mesme. Deri në mesin e kësaj jave , këto marrëveshje në përgjithësi konsideroheshin të ligjshme. Megjithatë, ato kanë kufizime në hartimin e tyre: sistemi kompjuterik merret me qira në vend që të jetë në pronësi, kapaciteti ndahet në vend që të dedikohet, dhe afatet e vendosjes varen nga operatorët e palëve të treta në vend që të jenë të brendshme në skenarët më të këqij.

Nuk është çudi që përdorimi i pajisjeve në distancë për të trajnuar modelet e inteligjencës artificiale në nivel fronti është i ndërlikuar, pasi ndryshimi midis marrjes me qira të Rubin në një qendër të dhënash cloud në distancë dhe vendosjes së tij në nivel lokal është i thellë. Hipershkallëzuesit amerikanë mund të integrojnë përshpejtuesit Rubin në shkallë të gjerë, të akordojnë fort programet e tyre rreth pajisjeve të reja dhe të rezervojnë grupe masive GPU për trajnime të gjata. Në të kundërt, zhvilluesit kinezë që planifikojnë të marrin me qira kapacitetin e Rubin do të duhet të përballen me alokime të kufizuara, vonesë ndërkufitare, liri të kufizuar për të personalizuar sistemet dhe, në disa raste, radhë. Nëse marrin me qira mjaftueshëm sisteme – dhe ka qendra të dhënash cloud në SHBA që aktualisht përdorin qindra mijëra GPU Blackwell – ata mund të trajnojnë modelet e tyre pa shumë telashe. Megjithatë, nëse nuk mund të gjejnë cloud të përshtatshëm në kohë, ata do të kenë më pak përshpejtues të inteligjencës artificiale për projekt dhe, në disa raste, nuk do të jenë në gjendje të kryejnë punë të mëdha trajnimi, të cilat do të kufizojnë drejtpërdrejt madhësinë e modelit, kadencën e eksperimentimit dhe shpejtësinë e përsëritjes.

Ndërkohë, trajnimi i ndërlikuar dhe joefikasitetet janë të njohura për zhvilluesit kinezë që përdorën flota të ndryshme GPU-sh Nvidia, të përbëra nga A100, H100, H800 dhe H20, për të trajnuar modelet e tyre të përparuara. Meqenëse nuk mund ta siguronin zyrtarisht Blackwell, ata i morën me qira edhe në cloud dhe burimet e brendshme thonë se përvoja ishte e kushtueshme dhe e vështirë nga ana operative, sipas WSJ . Si rezultat, ata tashmë dinë si të luftojnë joefikasitetet.

Me modelin frontier të gjeneratës së ardhshme dhe GPU-të Rubin, gjërat do të bëhen edhe më të ndërlikuara. Ndërsa modelet zgjerohen, vlera e aksesit të pandërprerë në grupe të mëdha dhe homogjene GPU rritet, dhe kapaciteti i marrë me qira rrallë e ofron këtë. Edhe nëse marrëveshjet sigurohen (gjë që nuk është e garantuar, duke pasur parasysh kufizimet e reja në aksesin në cloud), ato zakonisht i lënë zhvilluesit kinezë në një disavantazh strukturor në krahasim me konkurrentët amerikanë të financuar mirë që mund të vendosin dhjetëra mijëra përshpejtues nën një çati.

Ekziston një ndërlikim tjetër. UBS vlerëson se kompanitë kineze me shkallë më të lartë shpenzuan rreth 57 miliardë dollarë për shpenzime kapitale vitin e kaluar, që është afërsisht 1/10 e shpenzimeve kapitale të konkurrentëve amerikanë. Për ta vënë shifrën në kontekst, kjo është më pak se shpenzimet kapitale të Metës të vitit të kaluar prej mbi 70 miliardë dollarësh. Duke pasur parasysh kufizimet financiare, mbetet për t’u parë nëse zhvilluesit kinezë të inteligjencës artificiale do të jenë në gjendje të qëndrojnë pak a shumë konkurrues me konkurrentët e tyre nga Amerika.