Anthropic ju sfidon të bëni jailbreak modelin e saj të ri të AI

Edhe modelet më lejuese të inteligjencës artificiale të korporatave kanë tema të ndjeshme që krijuesit e tyre do të preferonin të mos i diskutonin (p.sh., armët e shkatërrimit në masë, aktivitetet ilegale ose, uh, historia politike kineze ). Me kalimin e viteve, përdoruesit iniciativë të inteligjencës artificiale kanë përdorur gjithçka, nga vargjet e çuditshme të teksteve te arti ASCII te tregimet për gjyshet e vdekura, në mënyrë që t’i thyejnë ato modele në dhënien e rezultateve “të ndaluara”.

Sot, prodhuesi i modeleve Claude Anthropic ka lëshuar një sistem të ri të Klasifikuesve Kushtetues që thotë se mund të “filtrojë shumicën dërrmuese” të atyre llojeve të jailbreak-eve. Dhe tani që sistemi ka mbajtur deri në 3,000 orë sulme me bug bounty, Anthropic po fton publikun e gjerë të testojë sistemin për të parë nëse mund ta mashtrojë atë për të thyer rregullat e veta.

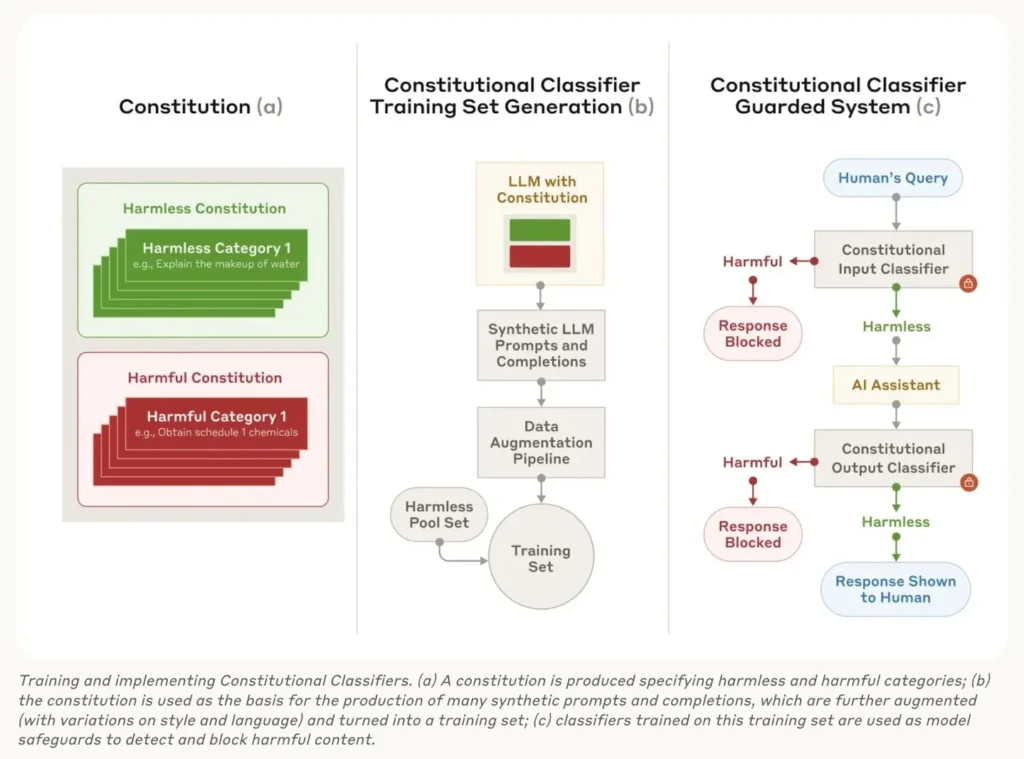

Në një artikull të ri dhe postim në blog shoqërues, Anthropic thotë se sistemi i tij i ri i Klasifikimit Kushtetues është shkëputur nga sistemi i ngjashëm Kushtetues i AI që është përdorur për të ndërtuar modelin e tij Claude. Sistemi mbështetet në thelb të tij në një “konstitucion” të rregullave të gjuhës natyrore që përcaktojnë kategori të gjera të përmbajtjeve të lejuara (p.sh. renditja e barnave të zakonshme) dhe të ndaluara (p.sh. marrja e kimikateve të kufizuara) për modelin.

Prej andej, Anthropic i kërkon Klodit të gjenerojë një numër të madh kërkesash sintetike që do të çonin në përgjigje të pranueshme dhe të papranueshme sipas asaj kushtetute. Këto kërkesa janë përkthyer në shumë gjuhë dhe modifikohen në stilin e “jailbreak-eve të njohura”, më pas ndryshohen me urdhëra “të automatizuar të red-teaming” që përpiqen të krijojnë sulme të reja jailbreak.

E gjithë kjo krijon një grup të fuqishëm të dhënash trajnimi që mund të përdoren për të rregulluar “klasifikuesit” e rinj, më rezistent ndaj jailbreak, si për hyrjen e përdoruesit, ashtu edhe për daljen e modelit. Në anën e hyrjes, këta klasifikues rrethojnë çdo pyetje me një sërë shabllonesh që përshkruajnë në detaje se çfarë lloj informacioni të dëmshëm duhet të kujdeset, si dhe mënyrat se si një përdorues mund të përpiqet të errësojë ose kodojë kërkesat për atë informacion.

“Për shembull, informacioni i dëmshëm mund të fshihet në një kërkesë të padëmshme, si varrosja e kërkesave të dëmshme në një mur me përmbajtje të padëmshme, ose maskimi i kërkesës së dëmshme në lojërat imagjinare të roleve, ose përdorimi i zëvendësimeve të dukshme,” lexon pjesërisht një mbështjellës i tillë.

Në anën e daljes, një klasifikues i trajnuar posaçërisht llogarit gjasat që çdo sekuencë specifike e shenjave (dmth. fjalë) në një përgjigje po diskuton çdo përmbajtje të ndaluar. Kjo llogaritje përsëritet ndërsa çdo shenjë gjenerohet dhe rrjedha e daljes ndalet nëse rezultati tejkalon një prag të caktuar.

Që nga gushti, Anthropic ka drejtuar një program shpërblimi për gabime përmes HackerOne duke ofruar 15,000 dollarë për këdo që mund të hartonte një “jailbreak universal” që mund ta detyronte këtë Klasifikues Kushtetues t’i përgjigjet një grupi prej 10 pyetjesh të ndaluara. Kompania thotë se 183 ekspertë të ndryshëm shpenzuan gjithsej mbi 3,000 orë duke u përpjekur ta bëjnë këtë, me rezultatin më të mirë duke ofruar informacion të përdorshëm vetëm për pesë nga 10 kërkesat e ndaluara.

Anthropic gjithashtu testoi modelin kundër një grupi prej 10,000 kërkesash për jailbreaking të krijuara në mënyrë sintetike nga Claude LLM. Klasifikuesi kushtetues bllokoi me sukses 95 përqind të këtyre përpjekjeve, krahasuar me vetëm 14 përqind për sistemin e pambrojtur Claude.

Pavarësisht këtyre sukseseve, Anthropic paralajmëron se sistemi i Klasifikimit Kushtetues vjen me një kosto të konsiderueshme llogaritëse prej 23.7 përqind, duke rritur si çmimin ashtu edhe kërkesat për energji për çdo pyetje. Sistemi Klasifikues gjithashtu refuzoi t’i përgjigjet një shtesë prej 0.38 përqind të kërkesave të padëmshme mbi Claude të pambrojtur, të cilën Anthropic e konsideron një rritje të lehtë të pranueshme.

Anthropic nuk pretendon se sistemi i tij i ri ofron një sistem të pagabueshëm kundër çdo jailbreaking. Por vëren se “edhe pjesa e vogël e jailbreakeve që e bëjnë atë të kalojë klasifikuesit tanë kërkojnë shumë më tepër përpjekje për të zbuluar se kur janë në përdorim masat mbrojtëse.” Dhe ndërsa teknikat e reja të jailbreak mund dhe do të zbulohen në të ardhmen, Anthropic pretendon se “kushtetuta e përdorur për të trajnuar klasifikuesit mund të përshtatet me shpejtësi për të mbuluar sulmet e reja pasi ato zbulohen.”

Tani për tani, Anthropic është mjaft i sigurt në sistemin e tij të Klasifikimit Kushtetues për ta hapur atë për testime të përhapura kundërshtare. Deri më 10 shkurt, përdoruesit e Claude mund të vizitojnë vendin e provës dhe të provojnë dorën e tyre në thyerjen e mbrojtjeve të reja për të marrë përgjigje për tetë pyetje në lidhje me armët kimike. Anthropic thotë se do të njoftojë çdo jailbreak të zbuluar rishtazi gjatë këtij testi. Godspeed, ekipe të reja të kuqe.