Cohere me burime të hapura seria Aya 23 e LLM-ve shumëgjuhëshe

Cohere Inc. prezantoi sot Aya 23, një familje e re e modeleve të gjuhëve të mëdha me burim të hapur që mund të kuptojë 23 gjuhë.

Cohere me bazë në Toronto është një konkurrent i OpenAI i mbështetur nga më shumë se 400 milionë dollarë fonde nga Nvidia Corp., Oracle Corp. dhe investitorë të tjerë. Ai siguron një grup LLM-sh të optimizuara për tregun e ndërmarrjeve. Kompania ofron gjithashtu Embed, një rrjet nervor i krijuar për t’i kthyer të dhënat në struktura matematikore që modelet gjuhësore mund t’i kuptojnë më lehtë.

Në fillim, seria e sapo debutuar Aya 23 LLM përbëhet nga dy algoritme. E para përmban 8 miliardë parametra dhe është projektuar për rastet e përdorimit që kërkojnë një ekuilibër midis cilësisë së përgjigjes dhe performancës. Për zhvilluesit me kërkesa më të avancuara, Cohere ka ndërtuar një version më të madh të Aya që përmban 35 miliardë parametra.

Edicioni i fundit, i cili njihet si Aya-23-35B, bazohet në një LLM të quajtur Command R që kompania prezantoi marsin e kaluar. Ishte modeli kryesor i AI i Cohere deri në prillin e kaluar, kur debutoi një algoritëm më të avancuar. Command R mbështet kërkesat me deri në 128,000 shenja, ofron një veçori të integruar RAG dhe mund të kryejë automatikisht detyrat në aplikacione të jashtme.

Nën kapuçin, Aya-23-35B bazohet në një dizajn standard të industrisë LLM të njohur si arkitektura Transformer vetëm me dekoder. Modelet që zbatojnë këtë dizajn përcaktojnë kuptimin e secilës fjalë në një kërkesë të përdoruesit duke analizuar kontekstin e fjalës, përkatësisht tekstin e mëparshëm. Algoritme të tilla mund të gjenerojnë rezultate më të sakta se shumë rrjete nervore të mëparshme.

Sipas Cohere, Aya-23-35B përmirëson arkitekturën standarde të Transformer-it vetëm me dekoder në disa mënyra. Përmirësimet e kompanisë kanë ndihmuar që modeli të jetë më i aftë për të kuptuar kërkesat e përdoruesve.

Shpesh, mekanizmi që lejon LLM-të të përcaktojnë kuptimin e një fjale bazuar në kontekstin e saj, shpesh nuk zbatohet si një modul i vetëm softueri. Përkundrazi, është një koleksion i disa moduleve softuerike që secili ka një qasje të ndryshme në interpretimin e tekstit. Aya 23 i zbaton ata komponentë me një qasje të quajtur vëmendje e pyetjeve të grupuara që ul përdorimin e RAM-it të tyre, gjë që përshpejton përfundimin.

Aya-23-35B zbaton gjithashtu një teknologji të quajtur embeddings pozicionale rrotulluese. Një LLM merr parasysh jo vetëm kuptimin e fjalëve, por edhe pozicionin e tyre brenda një fjalie për të interpretuar tekstin. Duke përdorur ngulitje të pozicionit rrotullues, LLM-të mund të përpunojnë informacionin e vendndodhjes së fjalëve në mënyrë më efektive, gjë që përmirëson cilësinë e prodhimit të tyre.

Cohere trajnoi Aya 23 në një të dhëna trajnimi shumëgjuhëshe, të quajtur gjithashtu Aya, që ishte me burim të hapur në fillim të këtij viti. Të dhënat e të dhënave përfshin 513 milionë kërkesa dhe përgjigje LLM në 114 gjuhë. Ai u zhvillua përmes një iniciative me burim të hapur që tërhoqi kontribute nga rreth 3,000 kontribues.

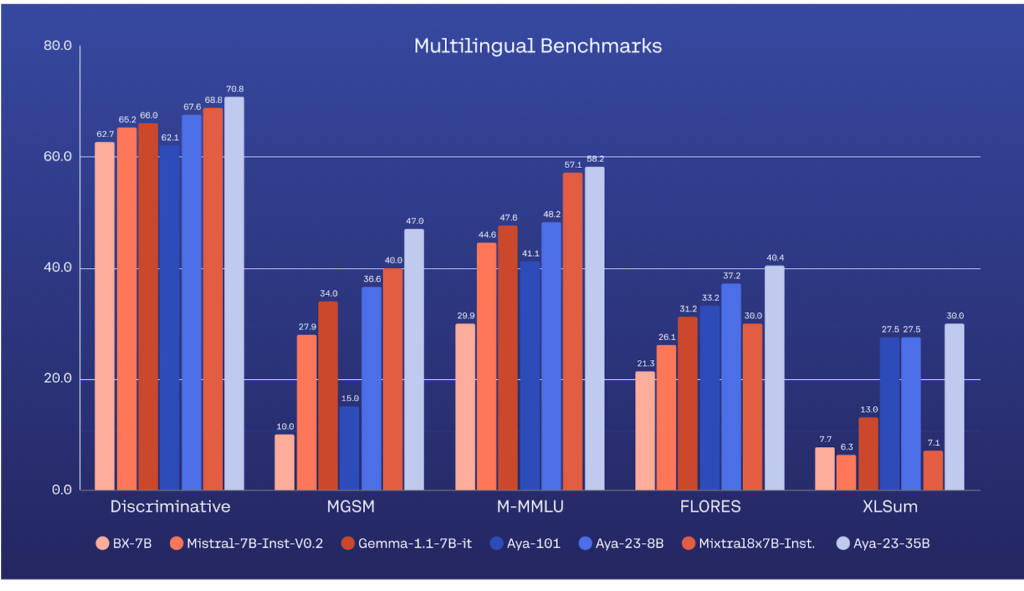

Projekti gjithashtu pa Cohere të lëshojë Aya-101, një LLM që kupton 101 gjuhë. Sipas kompanisë, modeli i saj i ri Aya-23-35B tejkaloi ndjeshëm algoritmin e mëparshëm në një seri vlerësimesh të brendshme. Ai gjithashtu u tregua më i aftë se disa LLM të tjera me burim të hapur në detyrat e përpunimit të tekstit shumëgjuhësh.