Google lanson TPU-të Ironwood dhe instancat e reja Axion, ndërsa kërkesa për inferencë të inteligjencës artificiale (AI) po rritet me shpejtësi

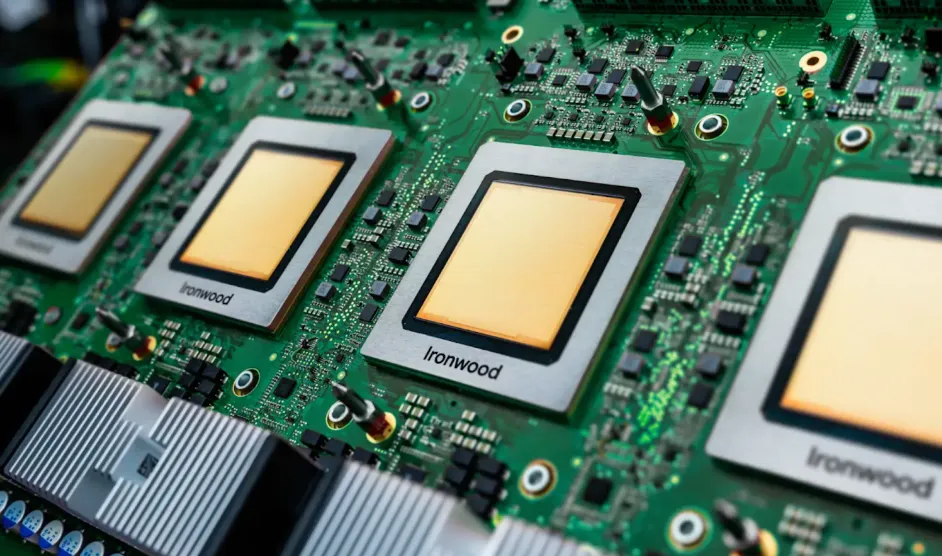

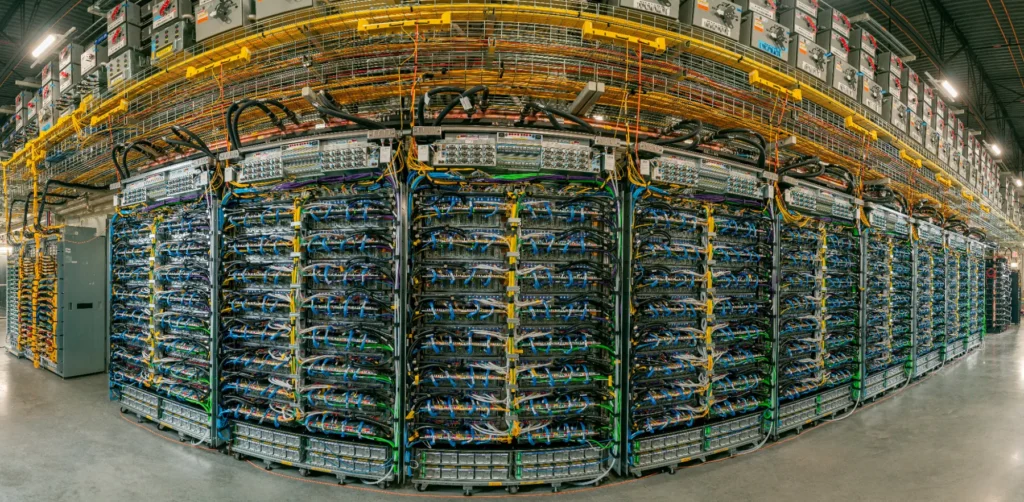

Google LLC njoftoi sot se po sjell në internet çipat e saj të personalizuar Ironwood për klientët e cloud-it, duke lançuar njësi përpunimi tensorësh që mund të shkallëzohen deri në 9,216 çipa në një pod të vetëm për t’u bërë arkitektura më e fuqishme e përshpejtuesit të IA-së e kompanisë deri më sot.

Çipat e rinj do të jenë në dispozicion të klientëve në javët në vijim, së bashku me instancat e reja Axion të bazuara në Arm që premtojnë deri në dyfishin e çmimit dhe performancës së alternativave aktuale të bazuara në x86.

Modelet e përparuara të Google, duke përfshirë Gemini, Veo dhe Imagen, trajnohen dhe vendosen duke përdorur TPU, së bashku me modele po aq të mëdha të palëve të treta, siç është Claude i Anthropic PBC. Kompania tha se ardhja e agjentëve të IA-së, të cilët kërkojnë arsyetim të thellë dhe menaxhim të avancuar të detyrave, po përcakton një epokë të re ku inferenca – inteligjenca në kohën e ekzekutimit të modeleve aktive – ka rritur shumë kërkesën për llogaritjen e IA-së.

Gjigandi i teknologjisë e prezantoi Ironwood në Google Cloud Next 2025 në prill dhe e cilësoi atë si përshpejtuesin më të fuqishëm TPU që kompania ka ndërtuar ndonjëherë.

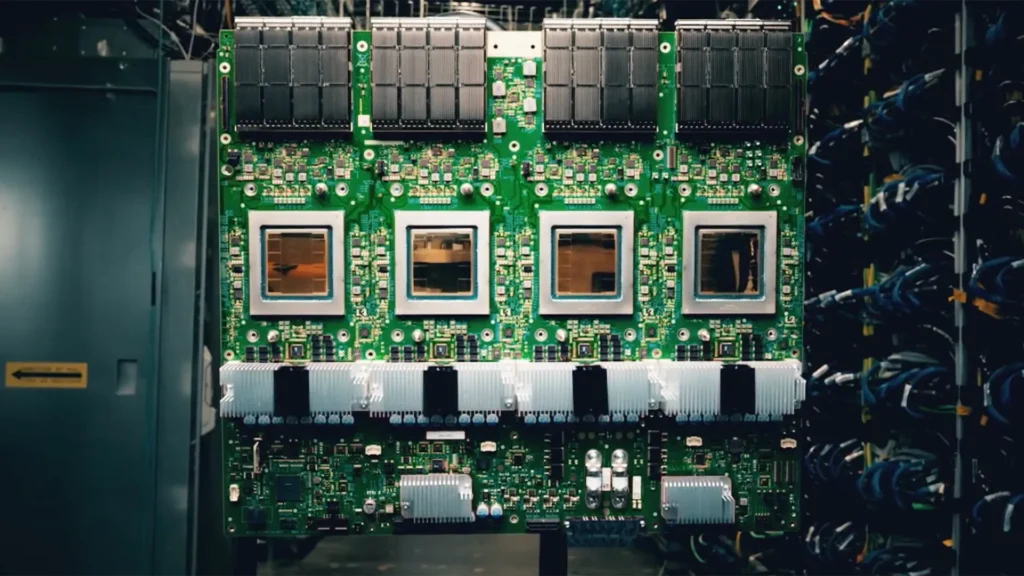

Arkitektura e gjeneratës së ardhshme i lejon kompanisë të shkallëzojë deri në 9,216 çipa në një server të vetëm, të lidhur së bashku me ndërlidhje ndërçipësh për të ofruar deri në 9.6 terabit për sekondë bandwidth. Ato mund të lidhen me një sasi kolosale prej 1.77 petabajt memorie të përbashkët me bandwidth të lartë ose HBM.

Ndërlidhja ndërçip, ose ICI, vepron si një “autostradë të dhënash” për çipat, duke i lejuar ata të mendojnë dhe të veprojnë si një tru i vetëm përshpejtues i IA-së. Kjo është e rëndësishme sepse modelet moderne të IA-së kërkojnë fuqi të konsiderueshme përpunimi, por ato nuk mund të përshtaten në çipa të vetëm dhe duhet të ndahen në qindra ose mijëra procesorë për përpunim paralel. Ashtu si mijëra ndërtesa të ngjeshura së bashku në një qytet, problemi më i madh me të cilin përballet ky lloj sistemi është mbingarkesa e trafikut. Me më shumë bandwidth, ato mund të komunikojnë më shpejt dhe me më pak vonesë.

HBM mirëmban sasinë e madhe të të dhënave në kohë reale që modelet e IA-së duhet të “mbajnë mend” kur trajnojnë ose përpunojnë pyetje nga përdoruesit. Sipas Google, 1.77 petabajt të dhënash të arritshme në një sistem të vetëm dhe të unifikuar janë lider në industri. Një petabajt i vetëm, ose 1,000 terabajt, mund të përfaqësojë rreth 40,000 filma Blu-ray me definicion të lartë ose tekstin e miliona librave. Duke i bërë të gjitha këto të arritshme menjëherë, modelet e IA-së të përgjigjen menjëherë dhe në mënyrë inteligjente me sasi të mëdha njohurish.

Kompania tha se arkitektura e re e pod-eve e bazuar në Ironwood mund të ofrojë më shumë se 118 herë më shumë FP8 ExaFLOPS sesa konkurrenti më i afërt dhe performancë 4 herë më të mirë për trajnim dhe nxjerrje përfundimesh sesa Trillium , gjenerata e mëparshme e TPU-së.

Google përfshiu një shtresë të re softueri mbi këtë harduer të përparuar të bashkë-projektuar për të maksimizuar aftësitë dhe memorien e Ironwood. Kjo përfshin një aftësi të re Cluster Director në Google Kubernetes Engine, e cila mundëson mirëmbajtje të avancuar dhe ndërgjegjësim për topologjinë për një planifikim më të mirë të proceseve.

Për trajnimin paraprak dhe pas trajnimit, kompania njoftoi përmirësime në MaxText, një kornizë trajnimi për modele të mëdha gjuhe me performancë të lartë dhe burim të hapur për zbatimin e teknikave të të mësuarit të përforcuar. Google gjithashtu njoftoi së fundmi përmirësime në vLLM për të mbështetur ndërrimin e inferencës midis GPU-ve dhe TPU-ve, ose një qasje hibride.

Anthropic, një përdorues i hershëm i Ironwood, tha se çipat ofruan përmirësime mbresëlënëse në çmim-performancë, duke i lejuar ata të shërbejnë modele masive Claude në shkallë të gjerë. Zhvilluesi dhe ofruesi kryesor i modeleve të IA njoftoi në fund të muajit të kaluar se planifikon të ketë akses në deri në 1 milion TPU .

“Klientët tanë, nga kompanitë Fortune 500 deri te startup-et, varen nga Claude për punën e tyre më kritike”, tha James Bradbury, Drejtor i Kompjuterëve në Anthropic. “Ndërsa kërkesa vazhdon të rritet në mënyrë eksponenciale, ne po rrisim burimet tona kompjuterike ndërsa shtyjmë kufijtë e kërkimit të IA-së dhe zhvillimit të produkteve.”

Google njoftoi gjithashtu zgjerimin e ofertave të saj Axion me dy shërbime të reja në versionin paraprak: N4A, makinat virtuale Axion të gjeneratës së dytë, dhe C4A metal , instancat e para bare-metal të kompanisë me bazë në Arm Ltd.

Axion është njësia qendrore e përpunimit e bazuar në Arm e kompanisë, e projektuar për të ofruar performancë me efikasitet energjetik për ngarkesa pune për qëllime të përgjithshme. Ekzekutivët e Google vunë në dukje se çelësi i filozofisë së dizajnit të Axion është përputhshmëria e tij me strategjinë e infrastrukturës së optimizuar për ngarkesën e punës të kompanisë. Ai përdor ekspertizën e Arm në dizajnin efikas të CPU-së për të ofruar përmirësime të konsiderueshme të performancës dhe përdorimit të energjisë krahasuar me procesorët tradicionalë x86.

“Procesorët Axion do të kenë performancë 30% më të lartë se procesorët më të shpejtë Arm të disponueshëm në cloud sot”, tha Mark Lohmeyer, nënkryetar dhe drejtor i përgjithshëm i IA-së dhe infrastrukturës kompjuterike në Google Cloud, në një transmetim ekskluziv në theCUBE, studion e transmetimit të drejtpërdrejtë të SiliconANGLE Media, gjatë Google Cloud Next 2024. “Ata do të kenë performancë 50% më të lartë se procesorët e krahasueshëm të gjeneratës x86 dhe efikasitet energjie 60% më të mirë se instancat e krahasueshme të bazuara në x86.”

Axion ofron efikasitet shumë më të lartë për rrjedhat e punës moderne të IA-së për qëllime të përgjithshme dhe mund të shoqërohet me përshpejtuesit e rinj të specializuar Ironwood për të trajtuar shërbimin kompleks të modeleve. Instancat e reja të Axion janë projektuar për të ofruar një bazë operative, siç është përgatitja e të dhënave me volum të lartë, gëlltitja, analiza dhe drejtimi i shërbimeve virtuale që strehojnë aplikacione inteligjente.

Instancat N4A mbështesin deri në 64 CPU virtuale dhe 512 gigabajt memorie DDR5, me mbështetje për llojet e makinave të personalizuara. Metali i ri C4A ofron servera fizikë të dedikuar me deri në 96 vCPU dhe 768 gigabajt memorie. Këto dy shërbime të reja i bashkohen instancave C4A të njoftuara më parë nga kompania, të dizajnuara për performancë të lartë të vazhdueshme.